揭秘AI幻觉:GPT-4V存在视觉编码漏洞,清华联合NUS提出LLaVA-UHD

文章摘要

【关 键 词】 GPT-4V、多模态模型、视觉编码、漏洞分析、LLaVA-UHD

GPT-4V的推出标志着多模态大模型研究的新篇章,它在多模态问答、推理和交互等领域展现了卓越的能力。

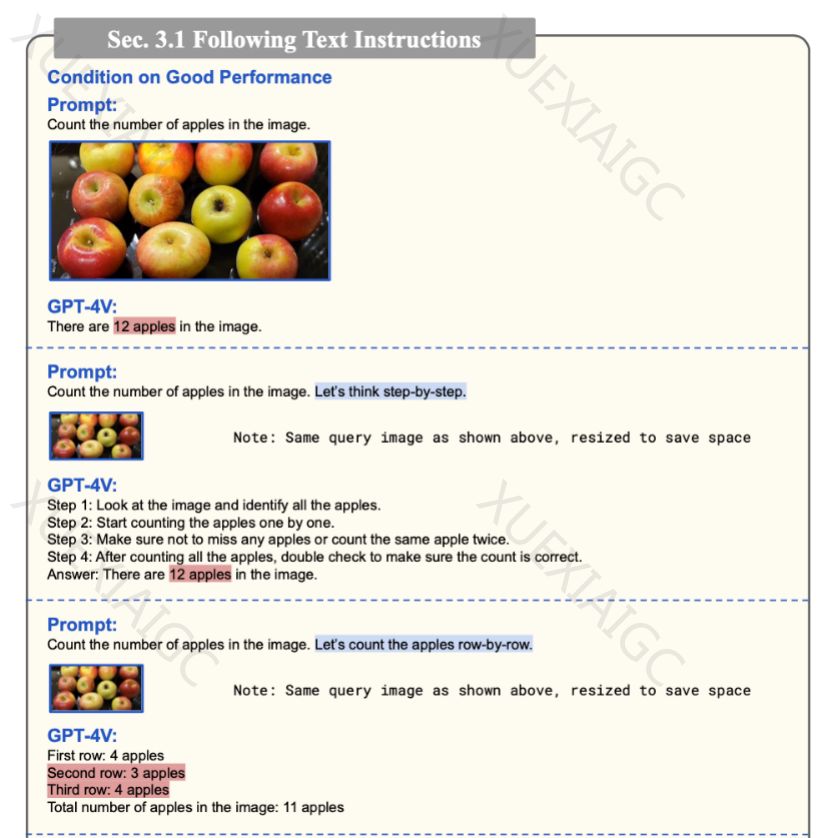

然而,一些研究揭示了GPT-4V在基本能力上的不足,尤其是在处理图像任务时的计数问题。微软的技术报告和清华大学、新加坡国立大学以及中国科学院大学的研究都指出了GPT-4V在视觉编码上的漏洞。

研究者通过实验发现,GPT-4V在处理图像时,如果图像分辨率无法被512整除,会导致图像切片重叠,从而引发计数错误。这种重叠导致的错误可能是数量翻倍或四倍。此外,图像分辨率的变化也会影响GPT-4V的计数回答,表现为显著的相位变化。这些发现表明,高分辨率图像处理时的重叠切片是导致错误响应的原因之一。

LLaVA-1.5作为一个受欢迎的开源多模态大模型,也存在视觉编码漏洞。为了处理不同长宽比的图像,LLaVA-1.5会将图像填充为正方形,这种方法导致了计算资源的浪费,并且模型无法区分填充像素和原始图像的实际部分。研究者通过实验展示了LLaVA-1.5在处理填充图像时的问题,模型会忽略填充区域,只关注中心矩形的颜色。

为了解决这些问题,研究者提出了LLaVA-UHD模型,它能够对任意长宽比的高分辨率图像进行编码,并在多个评测基准上实现了性能提升,同时降低了训练和推理的计算开销。LLaVA-UHD包括图像模块化策略、压缩模块和空间装饰模式,这些设计使得模型能够更高效地处理高分辨率图像,并提供了全局语义信息。

LLaVA-UHD在处理高分辨率图像方面的能力得到了实验验证,它能够准确识别课表、海报和手机上的密集文字内容。未来,研究者计划探索更高分辨率的图像处理,并改进视觉编码策略,以实现图像片段之间的高效连接和全局信息交互。

最后,机器之心还宣布了即将举办的AI技术论坛,聚焦于视频生成技术、多模态大模型等前沿领域,旨在帮助企业和从业者了解最新的技术进展。

原文和模型

【原文链接】 阅读原文 [ 2343字 | 10分钟 ]

【原文作者】 机器之心

【摘要模型】 gpt-4

【摘要评分】 ★★★★★