文章摘要

【关 键 词】 技术创新、开源模型、多语言处理、性能领先、AI应用

阿联酋阿布扎比技术创新研究所(TII)宣布开源其全新大模型Falcon 2,该模型包含110亿参数,分为两个版本:基础模型和视觉转换模型(VLM)。基础模型使用5.5万亿tokens数据进行预训练,能够生成文本、代码和总结内容,而VLM模型则能够将图片信息转换成文本数据,是少数支持视觉转换的开源大模型之一。

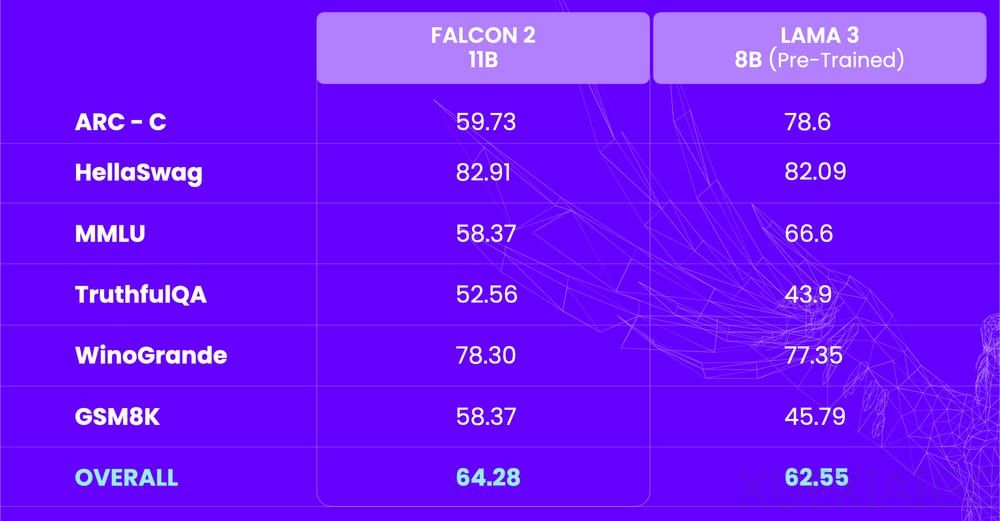

Falcon 2在多个维权测试排行榜中表现优异,性能超越Meta的Llama 3 8B,与Google的Gemma 7B并列第一。其多语言能力使其能够轻松处理英语、法语、西班牙语、德语和葡萄牙语等多种语言任务,增强了其多样性和跨场景有效性。

Falcon 2 11B VLM作为视觉大模型,在医疗保健、金融、电商、教育和法律等行业具有广泛的应用潜力,包括文档管理、数字存档、情境索引以及支持视障人士等。其训练数据基于TII构建的开源数据集RefinedWeb,使用了超过5.5万亿Tokens数据进行预训练。RefinedWeb是一个高质量、经过过滤和去重的网络数据集,TII通过精选语料对其进行了增强,并采用了四阶段的训练策略,以提高上下文长度和性能。

Falcon 2在1024个A100 40GB GPU上训练了约2个月。作为一款性能强、消耗低的大模型,Falcon 2仅需一个GPU即可高效运行,使其高度可扩展,易于部署并集成到笔记本电脑等轻量级设备中。这使得Falcon 2非常适用于中小企业和个人开发者,并且允许进行商业化使用。

TII人工智能跨中心部门执行主任及代理首席研究员Dr. Hakim Hacid表示,随着生成式AI技术的演进,开发者认识到小型模型带来的诸多优势,如减少计算资源需求、满足可持续性标准以及提供增强的灵活性,能无缝融入边缘AI基础设施这一新兴大趋势中。Falcon 2作为一款消耗低且性能强的模型,融合了领先的视觉解读能力。

早在2023年5月25日,TII首次开源了Falcon-40B大模型,在huggingface的开源大语言模型排行榜中位列第一名,击败了LLaMa 65b、GPT4-X-Alpasta-30b、StableLM、RedPajama、LLaMa 30b等一系列著名开源模型。Falcon-40B在1万亿tokens数据集上进行训练,可用于文本问答、总结摘要、自动生成代码、语言翻译等,并支持特定业务场景微调。在斯坦福大学的HELM LLM基准测试中,Falcon-40B的算力消耗低于GPT-3、Chinchilla AI、PaLM-62B等知名大语言模型,但性能更出色。

TII成立于2020年,是阿布扎比高等教育和科技部(ADEK)旗下的研究机构。TII的目标是推动科学研究、开发前沿技术并将其商业化,以促进阿布扎比和阿联酋的经济发展。目前,TII拥有来自74个国家的800多名研究专家,发表了700多篇论文和25多项专利,是世界领先的科学研究机构之一。

原文和模型

【原文链接】 阅读原文 [ 960字 | 4分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆