文章摘要

【关 键 词】 数据污染、AI模型、数据集、污染检测、语料库

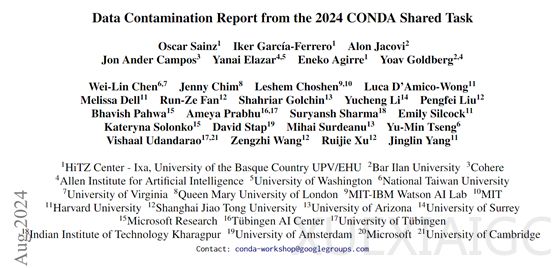

随着大语言模型(LLM)如GPT-4和o1的出现,生成式AI产品数量激增,但数据污染问题对模型的准确性和可靠性构成挑战。数据污染指评估数据无意中包含在预训练数据集中,影响模型评估结果。为研究此问题,包括麻省理工、上海交通、哈佛大学、微软研究院、IBM、剑桥大学等20多家机构联合召开了首届数据污染研讨会,收集并公布了数据集和模型中的数据污染证据。

研究人员通过公开拉取请求收集污染证据,并在接收前讨论。贡献者需提供受污染资源、评估数据集、污染百分比细分、论文参考及污染检测方法等信息,并提供证据或科学论文参考。报告包含42个受污染源、91个数据集和566个污染条目,涉及训练集、开发集、测试集和非污染事件。污染数据主要基于CommonCrawl快照、GitHub或多种来源组合。报告还涉及基于CommonCrawl的语料库、GitHub数据和Pile、ProofPile等语料库的污染事件。

受污染模型方面,大多数证据针对闭源模型,如GPT-3、GLaM、GPT-4等,但也有开源模型如FLAN、Mistral、Llama2等的污染事件。闭源模型虽难以验证,但受污染影响较大;开源模型虽透明,也存在污染现象。因此,无论闭源还是开源模型,都需谨慎处理和监控数据来源,减少污染。

报告还发现文本评分、问答和多项选择问答等任务类型污染严重,知名数据集如MMLU、GLUE和ai2_arc也存在污染。大多数报告数据集对应2018至2021年,最近发布的模型更易受最近数据集污染。例如,2020年的GPT-3主要受2016年数据集污染,而2023年的GPT-4主要受2018至2022年数据集污染。

原文和模型

【原文链接】 阅读原文 [ 947字 | 4分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★☆☆☆☆