当prompt策略遇上分治算法,南加大、微软让大模型炼成「火眼金睛」

模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

【摘要评分】 ★★★★★

文章摘要

【关 键 词】 大语言模型、分治算法、提示策略、幻觉检测、性能提升

摘要总结:

本文探讨了大语言模型(LLMs)在处理复杂任务时的局限性,并提出了一种新的基于分治算法的提示策略(Divide-and-Conquer, DaC),以提高模型在面对重复子任务和欺骗性内容时的表现。研究者们发现,通过将长输入拆分并分别处理,可以增强模型对错误信息的分辨能力,从而减少幻觉引发的中间错误。

研究动机源于实验中观察到的现象,即在处理涉及重复子任务和欺骗性内容的任务时,如虚假新闻检测,输入拆分能提升模型性能。研究者们通过对比耦合策略和分治策略,展示了分治策略在识别冲突点方面的优势。

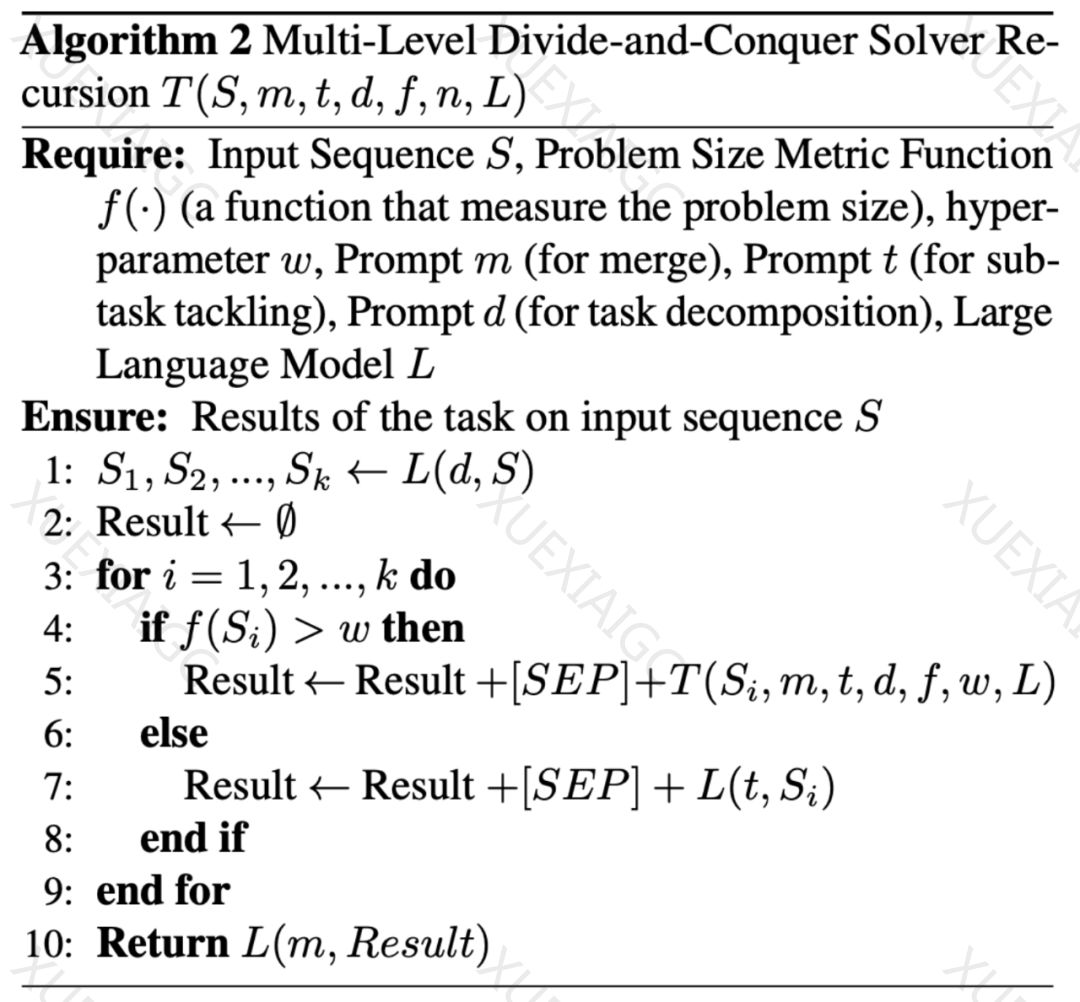

提出的分治提示策略包括三个子过程:子问题划分、子问题求解和子问题合并。这种方法允许模型并行处理子任务,增强了对中间错误的鲁棒性。研究者们还提出了单级和多级分治策略,以适应不同规模的任务。

理论分析表明,分治策略能够克服固定深度Transformer的表达能力限制。通过分治提示,即使是宽度和深度为常数的Transformer,也能在对数时间复杂度下解决NC1完全问题。

实验结果显示,新策略在大整数乘法、幻觉检测和新闻验证等任务上,相对于传统提示策略,取得了更高的准确率和更好的性能。这些结果验证了分治策略在处理复杂任务时的有效性。

文章最后提供了相关研究的引用,并指出转载需联系公众号获得授权。投稿或报道需求可发送至指定邮箱。

原文信息

【原文链接】 阅读原文

【阅读预估】 2071 / 9分钟

【原文作者】 机器之心

【作者简介】 专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...