文章摘要

【关 键 词】 开源大模型、Qwen1.5-110B、性能提升、社区响应、多语言支持

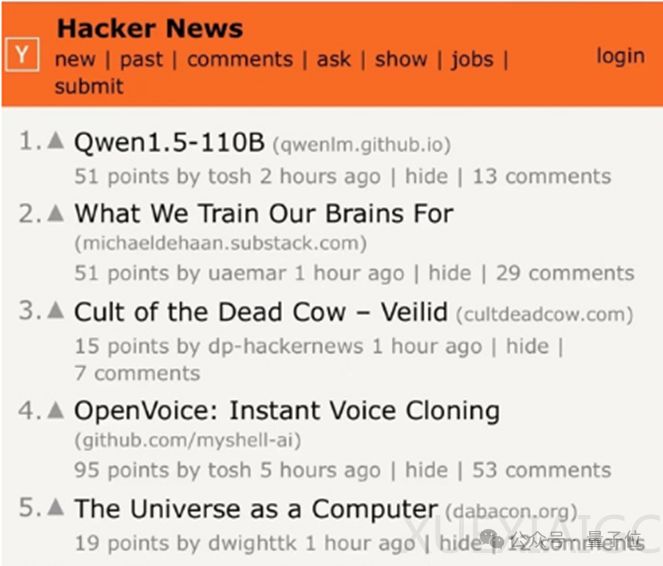

Qwen1.5-110B模型开源:国内通义千问开源了一款千亿级参数模型Qwen1.5-110B,该模型在多个基准测试中超越了Llama 3 70B,成为最强的开源大模型。

性能提升:Qwen1.5-110B相较于之前的720亿参数模型在性能上有明显提升,尤其在中文能力方面,优势更为明显。

社区响应:模型开源后,社区热烈响应,Ollama平台迅速上线,帮助用户在本地环境运行大语言模型。

尺度定律(Scaling Laws):文章提到了尺度定律在Llama 3和Qwen1.5-110B中的应用,强调了模型规模增加带来的性能提升,以及在模型大小扩展方面仍有很大的提升空间。

长文本和多语言能力:Qwen1.5-110B在长文本处理和多语言支持方面表现出色,支持包括中文、英文在内的多种语言,并且在12个较大的语言中表现不逊于GPT-3.5。

型号丰富度:开源模型的型号丰富度为用户提供了更多选择,尤其是在大模型应用向端侧转移的背景下。

阿里的开源策略:文章提到了阿里巴巴在开源大模型方面的积极态度,强调了其“把开源进行到底”的策略,并分析了其背后的技术层面和战略层面的考量。

开源与闭源模型的竞争:尽管闭源模型如GPT系列和Claude系列目前占据领先地位,但开源模型正不断取得新进展,形成激烈的竞争态势。

文章通过对比Qwen1.5-110B和Llama 3模型,展示了开源大模型在性能、中文处理能力、长文本处理和多语言支持方面的优势,同时强调了开源社区对于这些模型的积极响应和支持。此外,文章还探讨了开源大模型的发展趋势,以及阿里巴巴在推动开源大模型发展方面的策略和动机。

原文和模型

【原文链接】 阅读原文 [ 3174字 | 13分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★