文章摘要

【关 键 词】 SOTA模型、智谱AI、CogVLM2、多模态融合、开源版本

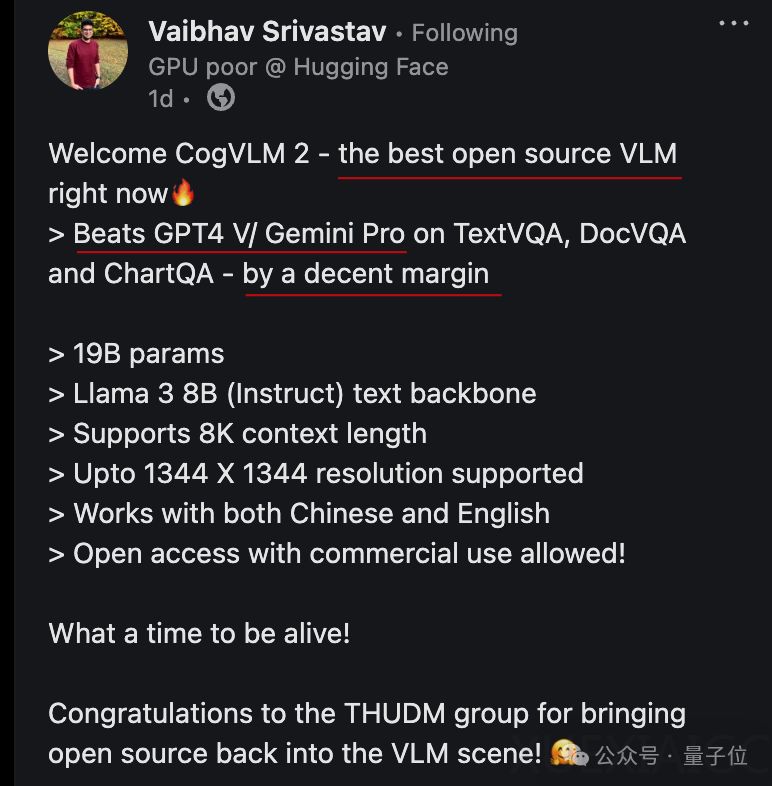

在最新的开源多模态SOTA模型竞争中,CogVLM2成功夺得王冠,由大模型创业公司智谱AI推出。该模型在OCRbench、TextVQA等三项关键基准测试中大幅领先于GPT-4v和Gemini Pro。

CogVLM2整体模型参数量仅为19B,却能在多项指标上达到或超过GPT-4V的水平,具有支持高达1344*1344图像分辨率、8K文本长度,并提供支持中英文双语的开源版本等亮点。

CogVLM2的多专家模块结构使得实际激活的参数量约为12B,从而降低了对显存的需求。Int4量化版本仅需16GB显存,可运行在RTX4080或RTX4070 Ti SUPER等显卡上。

CogVLM2在继承CogVLM一代核心思路的基础上,将视觉语言模型的训练方式推向深度融合,并在模型结构上做出优化。其视觉专家模块通过精细的参数设置,增强了视觉理解能力,同时保持了语言处理的优势。在支持中文方面,智谱AI团队通过在预训练和指令微调阶段加入大量中文图文数据和高质量中文指令数据,显著提升了模型的中文处理能力。

该模型的强大性能不仅体现在量化评估的多模态基准上,其在实际应用中的表现也同样出色,例如识别和描述复杂图像信息、处理中文手写和古代字体等。

最后,智谱AI团队透露,CogVLM2的能力将被整合进GLM新版本,并在智谱清言App和智谱AI大模型MaaS开放平台上线。CogVLM2的开源代码、模型下载和Demo体验等相关资源均已提供。

原文和模型

【原文链接】 阅读原文 [ 2203字 | 9分钟 ]

【原文作者】 量子位

【摘要模型】 glm-4

【摘要评分】 ★★★★★

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...