文章摘要

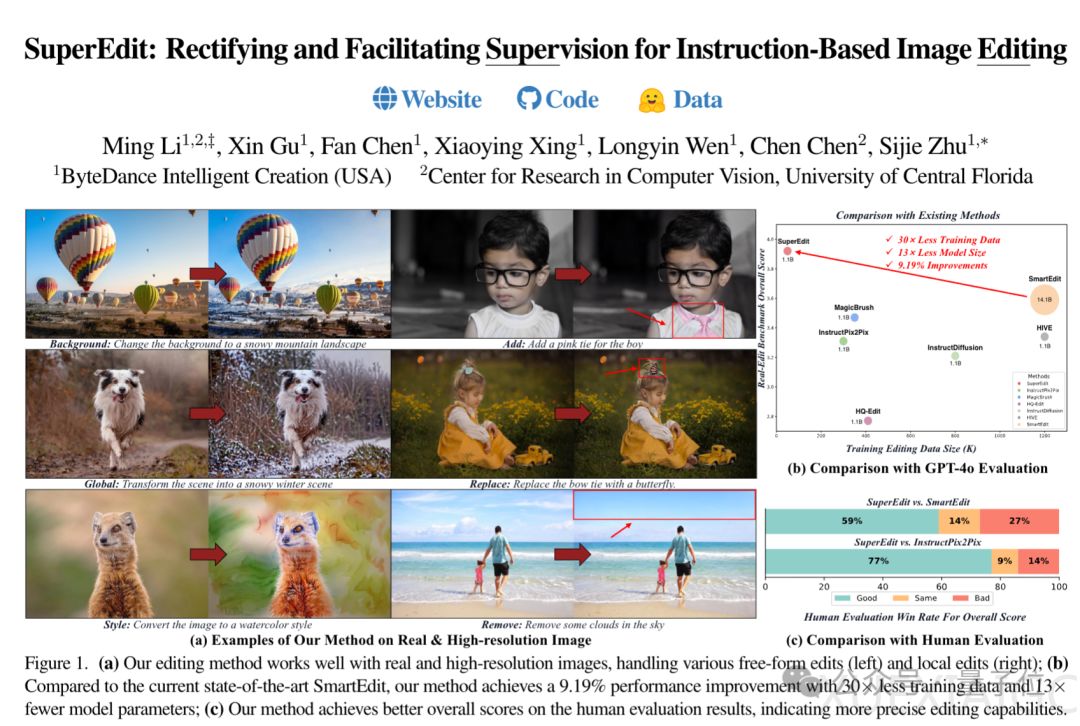

字节跳动最近开源了一种新的图像编辑方法,名为SuperEdit,该方法在性能上比当前最先进的图像编辑方法提高了9.19%,同时仅使用了1/30的训练数据和1/13的模型参数规模。这一方法的核心在于利用强大的多模态模型(如GPT-4o)来纠正编辑指令,从而提升图像编辑的效果。该方法无需额外的预训练任务或架构修改,专注于解决现有图像编辑模型中监督信号存在噪声的问题。

现有图像编辑模型常常出现“理解错误”的情况,例如当用户要求“给照片中的男孩加一条粉色领带”时,AI可能会错误地改变皮肤颜色、衣服颜色,甚至重绘整张图片。团队发现,这一问题源于现有图像编辑数据集中存在大量的噪声监督信号。当前基于指令的图像编辑方法依赖于大量原始-编辑后图像对和指令,但这些数据集通常通过自动化方法构建,导致指令与图像对之间的不匹配,从而产生噪声监督信号。这使得AI在学习时看到的指令与实际编辑效果不一致,导致模型“学废了”。

SuperEdit方法的关键在于通过GPT-4o生成更准确的编辑指令。团队发现,扩散模型在生成图像的不同阶段有着不同的侧重点:早期阶段关注全局布局变化,中期阶段关注局部物体属性变化,晚期阶段关注图像细节变化。基于这一发现,团队利用GPT-4o观察原始图像和编辑后图像之间的差异,生成更准确的编辑指令。这些指令涵盖了整体图像布局、局部对象属性、图像细节和样式变化四个方面。由于CLIP文本编码器最多接受77个文本token输入,团队还让GPT-4o对指令进行总结和完善。

为了进一步提升模型的理解能力,团队构建了一套对比监督机制。通过生成一系列错误指令(如改变物体数量、位置或颜色),并使用三元组损失函数(triplet loss)让模型学会区分正确和错误的编辑指令。由于正确指令和错误指令之间只替换了几个单词,CLIP文本编码器生成的文本嵌入作为扩散模型的输入也会非常相似。这种设计确保了学习任务的难度,帮助模型理解两个编辑指令之间的细微差异如何导致截然不同的编辑结果。

SuperEdit在多个基准测试中表现出色。在Real-Edit基准测试中,它以69.7%的整体准确率和3.91的评分,超越了前SOTA方法SmartEdit的58.3%准确率和3.59评分。在人工评估中,SuperEdit在指令遵循度、原始内容保留和图像质量三个关键指标上全面超越了现有方法。然而,该方法也存在一些局限,例如在处理复杂指令时仍然存在困难,尤其是在密集排列的对象和复杂的空间关系方面。此外,为确保校正指令的准确性和有效性,大量调用GPT-4o可能会产生额外的成本。

团队计划将这种数据优先的方法扩展到更多视觉生成任务中,并探索与更大模型相结合的可能性。

原文和模型

【原文链接】 阅读原文 [ 1047字 | 5分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-v3

【摘要评分】 ★★☆☆☆