模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

【摘要评分】 ★★★★☆

文章摘要

【关 键 词】 AI基础设施、字节跳动、万卡集群、MegaScale、GPU

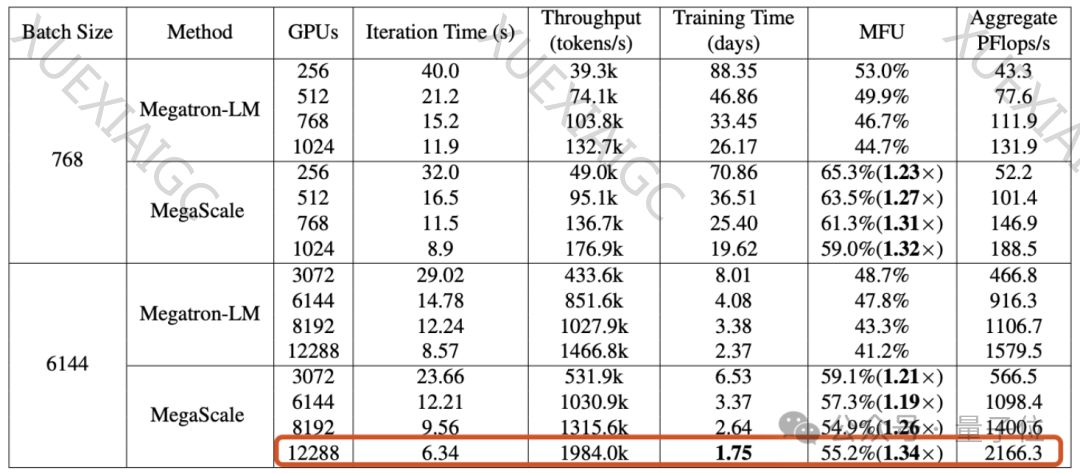

字节跳动与北京大学合作的一篇新论文揭示了AI基础设施的重要性,并介绍了字节搭建的万卡集群,该集群能在1.75天内完成GPT-3规模模型(175B)的训练。字节提出了MegaScale生产系统,以提高在大规模GPU集群上训练大模型的效率和稳定性。MegaScale在12288块GPU上实现了55.2%的算力利用率(MFU),是英伟达Megatron-LM的1.34倍。此外,字节已建立超过1万张Ampere架构GPU集群,并正在建设Hopper架构集群。MegaScale的改进包括算法优化、通信和计算重叠优化、操作符优化、数据流水线优化、网络性能调优和故障容忍等。实验结果显示,MegaScale能自动检测和修复超过90%的软硬件故障。同时,字节类Sora产品的AI视频工具已启动内测,预示着字节在大模型产品方面的进展。

摘要:

字节跳动与北京大学的合作研究展示了AI基础设施在大模型训练中的关键作用。字节的万卡集群能够快速完成大规模模型训练,而MegaScale生产系统则进一步提升了训练效率和稳定性。通过一系列技术优化,MegaScale在大规模GPU集群上实现了显著的算力利用率。字节的这些进展不仅展示了其在AI领域的技术实力,也为未来的大模型产品开发奠定了基础。随着字节类Sora产品的AI视频工具进入内测阶段,市场对字节在AI领域的进一步发展充满期待。

原文信息

【原文链接】 阅读原文

【阅读预估】 1332 / 6分钟

【原文作者】 量子位

【作者简介】 追踪人工智能新趋势,关注科技行业新突破

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...