国产开源模型,代码能力比肩 Claude,DeepSeek-V3 正式发布

文章摘要

【关 键 词】 DeepSeek-V3、开源模型、性能卓越、中文能力、FP8训练

DeepSeek 近日发布了其最新系列模型 DeepSeek-V3 的首个版本,并已开源上线。该模型以其卓越的代码能力受到关注,被认为与行业领先的 Claude Sonnet 3.5 相媲美。用户可以通过官网 chat.deepseek.com 与 V3 模型进行对话,API 服务也已更新,但当前版本不支持多模态输入输出。

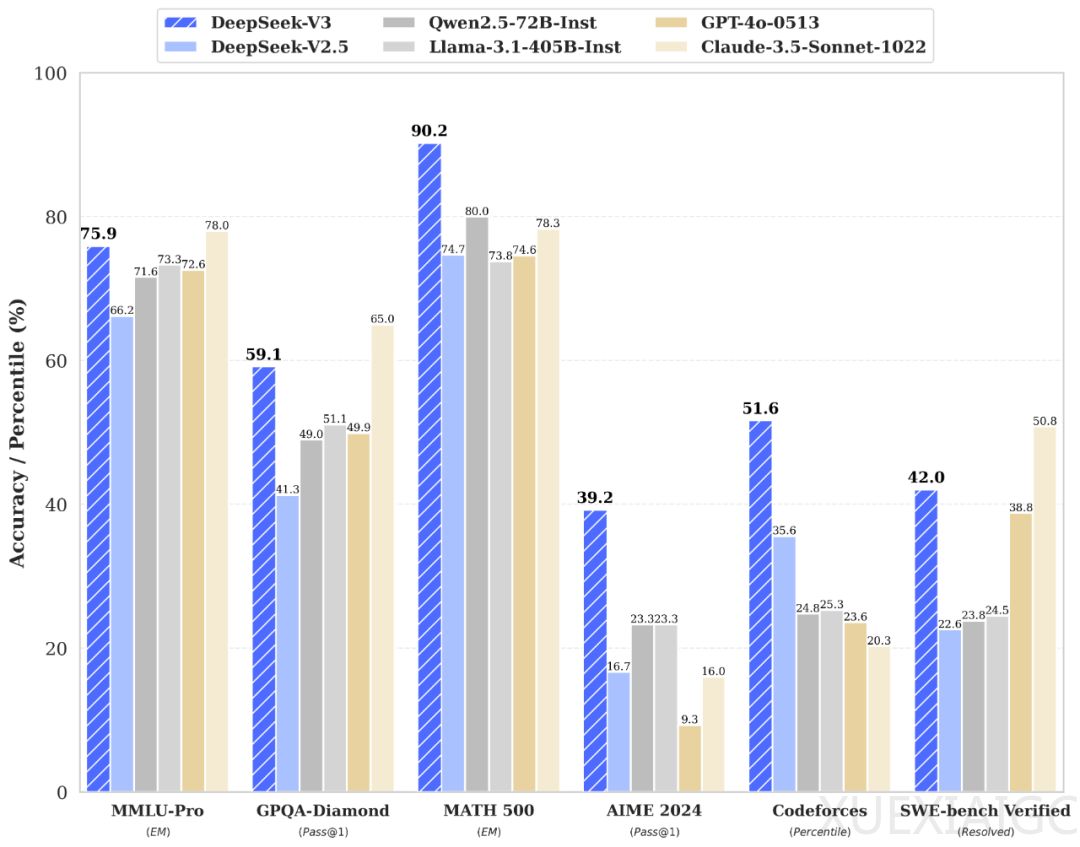

DeepSeek-V3 是一个自研的 MoE 模型,拥有 671B 参数和 37B 激活,在 14.8T token 上完成预训练。其性能在多个评测中超越了其他开源模型,与世界顶尖闭源模型如 GPT-4o 和 Claude-3.5-Sonnet 性能相当。在百科知识任务、长文本测评、代码场景和数学竞赛中,DeepSeek-V3 均展现出优异的表现,尤其在算法类代码场景中领先市场所有非 o1 类模型,并在工程类代码场景中接近 Claude-3.5-Sonnet-1022 的水平。此外,DeepSeek-V3 在中文能力方面也表现出色。

在生成速度方面,DeepSeek-V3 从 V2.5 的 20 TPS 提升至 60 TPS,实现了三倍提升,为用户提供了更快速流畅的体验。随着新模型的上线,API 服务价格也进行了调整,每百万输入 tokens 定价为 0.5 元(缓存命中)/ 2 元(缓存未命中),每百万输出 tokens 定价为 8 元。同时,DeepSeek 提供了长达 45 天的优惠价格体验期,直至 2025 年 2 月 8 日,期间价格为每百万输入 tokens 0.1 元(缓存命中)/ 1 元(缓存未命中),每百万输出 tokens 2 元。

DeepSeek-V3 采用 FP8 训练,并开源了原生 FP8 权重,得到了社区的广泛支持。SGLang 和 LMDeploy 支持了 V3 模型的原生 FP8 推理,TensorRT-LLM 和 MindIE 实现了 BF16 推理。为了方便社区适配和拓展应用场景,DeepSeek 提供了从 FP8 到 BF16 的转换脚本。模型权重下载和本地部署信息可在 Hugging Face 平台上找到。

DeepSeek 坚持开源精神和长期主义,致力于普惠 AGI。公司表示,将在 DeepSeek-V3 基座模型上继续开发更多功能,并与社区分享最新的探索成果。

原文和模型

【原文链接】 阅读原文 [ 1111字 | 5分钟 ]

【原文作者】 Founder Park

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆