文章摘要

【关 键 词】 扩散模型、逆诅咒、双向依赖、上下文学习、反转推理

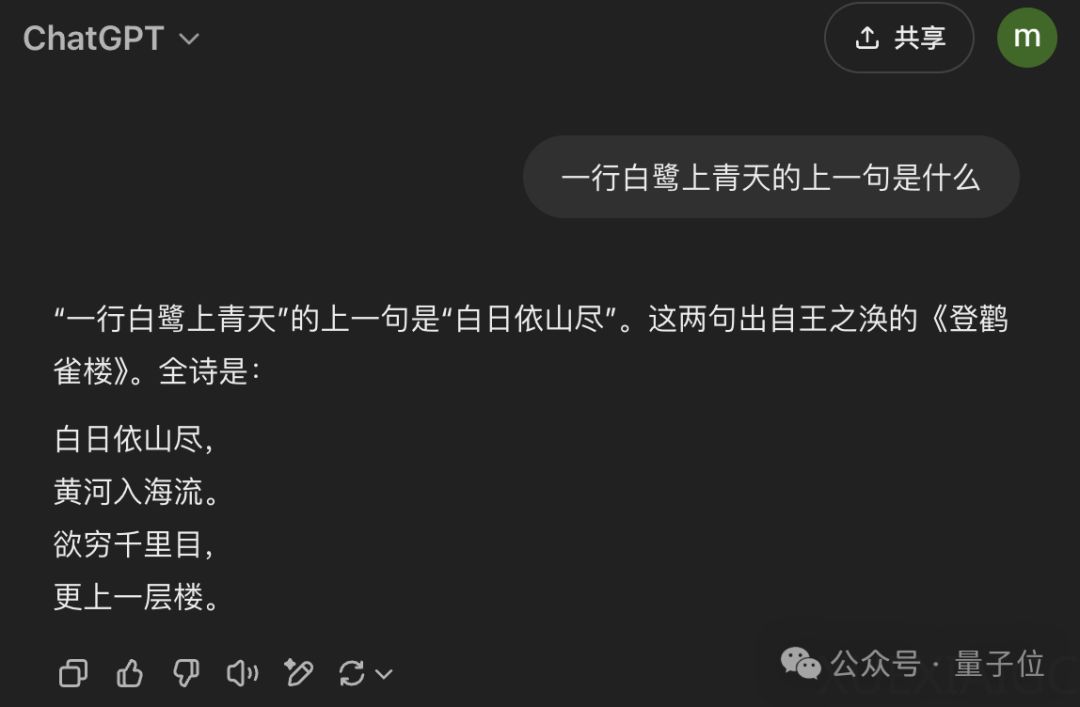

由中国人民大学高瓴人工智能研究院与蚂蚁集团联合研发的LLaDA模型,通过创新性引入扩散模型架构,为破解大语言模型的逆诅咒难题提供了全新解决方案。该模型在反转诗歌任务中展现出超越GPT-4o的性能,并在上下文学习能力上与LLaMA3-8B持平,标志着非自回归模型在大语言模型领域的重大突破。

传统自回归模型因单向生成机制存在显著局限,尤其在需要逆向推理的任务中表现欠佳。LLaDA采用双向依赖建模的扩散模型架构,通过正向掩码与反向预测机制,突破自回归模型的序列生成限制。其核心创新在于利用随机动态掩码策略替代固定比例掩码,使模型能更有效地捕捉文本双向语义关联。训练过程中使用2.3万亿token数据集和13万H800 GPU时,最终扩展至80亿参数规模。

在性能表现方面,LLaDA展现出三大核心优势:在MMLU和GSM8K等六项基准测试中,其扩展性与自回归基线模型相当;零样本/少样本学习任务超越LLaMA2-7B并持平LLaMA3-8B;多轮对话等指令遵循任务通过监督微调显著提升能力。特别在反转诗歌任务中,模型通过逐步预测完全掩码序列的生成机制,成功解决自回归模型逆向推理的固有缺陷。

技术实现层面,LLaDA采用非因果掩码的Transformer架构,通过随机重掩码、低置信度重掩码等采样策略平衡生成质量与效率。动态掩码机制允许每个token独立设定掩码概率,相比传统BERT固定15%掩码比例,在大规模训练中表现出更强适应性。监督微调阶段针对对话生成等任务特点,选择性掩码响应部分token以强化任务相关模式学习。

该研究引发学术界对模型架构演进的深度思考,部分研究者认为这种范式可能推动检索增强生成(RAG)与嵌入式相似性搜索的性能突破。尽管当前成果显著,业界仍关注其实际应用潜力——模型虽在数学推理、编程问题解决等场景展现能力,但如何与现有技术栈整合尚需验证。研究团队开源了项目代码与演示页面,为后续探索提供基础。

原文和模型

【原文链接】 阅读原文 [ 1674字 | 7分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-r1

【摘要评分】 ★★★★☆