文章摘要

在AI领域,大规模语言模型(LLMs)已经展示了强大的推理能力,但高昂的计算成本和延迟问题依然是一个重大挑战。最近,Zoom的研究团队提出了一种全新的推理范式——「草稿链(Chain-of-Draft, CoD)」,旨在通过模仿人类的简洁思维过程,提升AI的推理效率,从而显著降低成本。数据显示,使用CoD可以将Token使用减少80%,同时保持与「思维链(Chain-of-Thought, CoT)」相当的准确性。

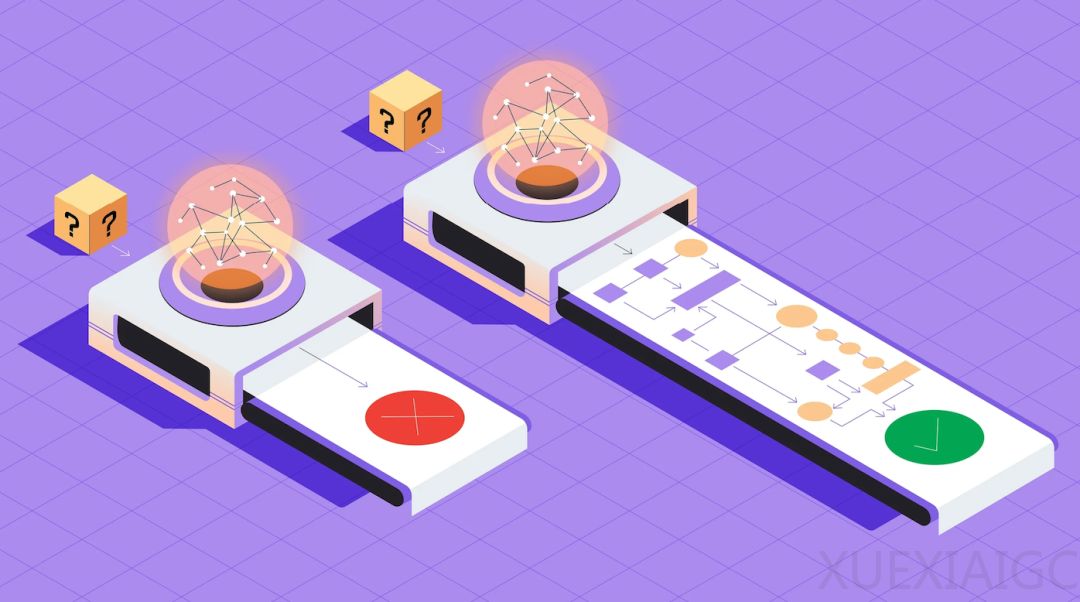

传统的「思维链」方法鼓励模型将问题分解成一步步的推导,类似于人类在纸上写下完整的解题过程。尽管这一方法有效,但它在推理时需要大量的计算资源,导致输出冗长且延迟较高。相比之下,人类在解决问题时通常依赖简洁的草稿或速记来捕捉必要的见解,而不做不必要的详细阐述。受此启发,Zoom团队提出了「草稿链」这一新范式,鼓励模型生成极简的中间推理步骤,只要捕捉解决问题的关键信息。

通过实验,Zoom团队发现,草稿链在算术推理、常识推理和符号推理任务中表现优异,不仅减少了冗余,还显著降低了计算成本和延迟。例如,在算术推理任务中,使用草稿链的GPT-4o和Claude 3.5 Sonnet模型在GSM8k数据集上的准确率分别为91.1%和91.4%,而思维链的准确率分别为95.4%和95.8%。尽管草稿链的准确率略低,但它将Token使用减少了80%,并将延迟降低了76.2%和48.4%。

此外,草稿链在常识推理和符号推理任务中同样表现出色。例如,在掷硬币任务中,草稿链将GPT-4o的Token使用减少了68%,而Claude 3.5 Sonnet的Token使用减少了86%,同时保持了100%的准确率。这些结果表明,草稿链在保持高准确性的同时,能够显著降低计算成本和延迟,使其在成本敏感的场景中具有广泛的应用潜力。

然而,草稿链也有其局限性。对于需要大量反思、自我纠正或外部知识检索的任务,它可能效果较差。此外,OpenAI在3月10日发文提到,他们相信「思维链监控」可能是未来监督超人类模型的少数工具之一,建议不要对前沿推理模型的CoT施加强烈的优化压力,保持CoT不受限制,以便进行监控。因为模型通常会在「思维链」中非常清楚地陈述其意图,让人类可以看到模型的思维,从而检测模型一些不当行为。

无论如何,从「思维链」到「草稿链」,AI推理范式还在不断进化。随着应用场景的扩展,成本与速度越来越成为绕不过的关键指标。CoD的出现,证明了人们依然在探索如何在保持大模型进步的前提下,进一步降低成本,加速AI的普及。

原文和模型

【原文链接】 阅读原文 [ 1974字 | 8分钟 ]

【原文作者】 极客公园

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆