文章摘要

【关 键 词】 DBRX、开源模型、MoE架构、Databricks、模型训练

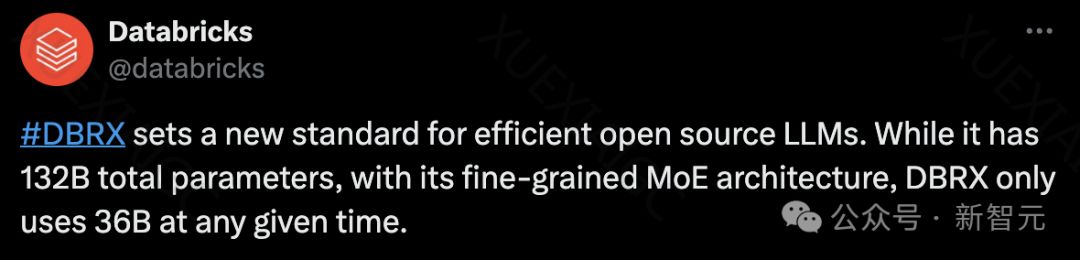

Databricks公司发布了全球最强开源模型DBRX,超越了Llama 2、Mixtral和Grok-1。DBRX采用了细粒度MoE架构,每次输入仅使用360亿参数,实现了更快的每秒token吞吐量,推理速度比LLaMA 2-70B快了2倍。训练成本直接砍半,只用了1000万美元和3100块H100,Databricks就在2个月内完成了DBRX的开发。DBRX在语言理解、编程、数学和逻辑方面轻松击败了开源模型LLaMA2-70B、Mixtral,以及Grok-1,甚至在整体性能上超越了GPT-3.5。

DBRX是一种基于Transformer纯解码器的大模型,采用下一token预测进行训练。它采用的是细粒度专家混合(MoE)架构,也就是具有更多的专家模型。DBRX大约有1320亿个参数,但处理一个典型查询,平均只需激活约360亿个参数,这就提高了底层硬件的利用率,将训练效率提高了30%到50%。DBRX还使用了旋转位置编码(RoPE)、门控线性单元(GLU)和分组查询注意力(GQA),并使用tiktoken存储库中提供的GPT-4分词器。

DBRX模型在12万亿Token的文本和代码进行预训练,支持的最大上下文长度为32k。研究人员估计,这些数据比用来预训练MPT系列模型的数据至少好2倍。这个新的数据集,使用全套数据库工具开发,包括用于数据处理的ApacheSpark™和Databricks笔记本,用于数据管理和治理的Unity Catalog,以及用于实验追踪的MLFlow。团队使用了「课程学习」(curriculum learning)进行预训练,并在训练过程中改变数据组合,大大提高了模型质量。

DBRX在综合基准、编程和数学基准以及MMLU上,刷新了开源AI的SOTA。与闭源模型GPT-3.5相比,DBRX Instruct的性能全面超越了它,还可与Gemini 1.0 Pro和Mistral Medium相较量。DBRX Instruct采用高达32K token上下文进行了训练。总体而言,MoE模型的推理速度,它们的总参数所显示的要快。这是因为它们对每个输入使用的参数相对较少。DBRX推理吞吐量是132B非MoE模型的2-3倍。

企业可以在Databricks平台上访问DBRX,能在RAG系统中利用长上下文功能,还可以在自己的私有数据上构建定制的DBRX模型。而开源社区可以通过GitHub存储库和Hugging Face访问DBRX。

原文和模型

【原文链接】 阅读原文 [ 4239字 | 17分钟 ]

【原文作者】 新智元

【摘要模型】 gpt-4-32k

【摘要评分】 ★★★★★