作者信息

【原文作者】 财猫AI

【作者简介】 头像是猫粮

【微 信 号】 caimaoAI

文章摘要

【关 键 词】 语言模型、安全性研究、数据过滤、隐私泄露、越狱攻击

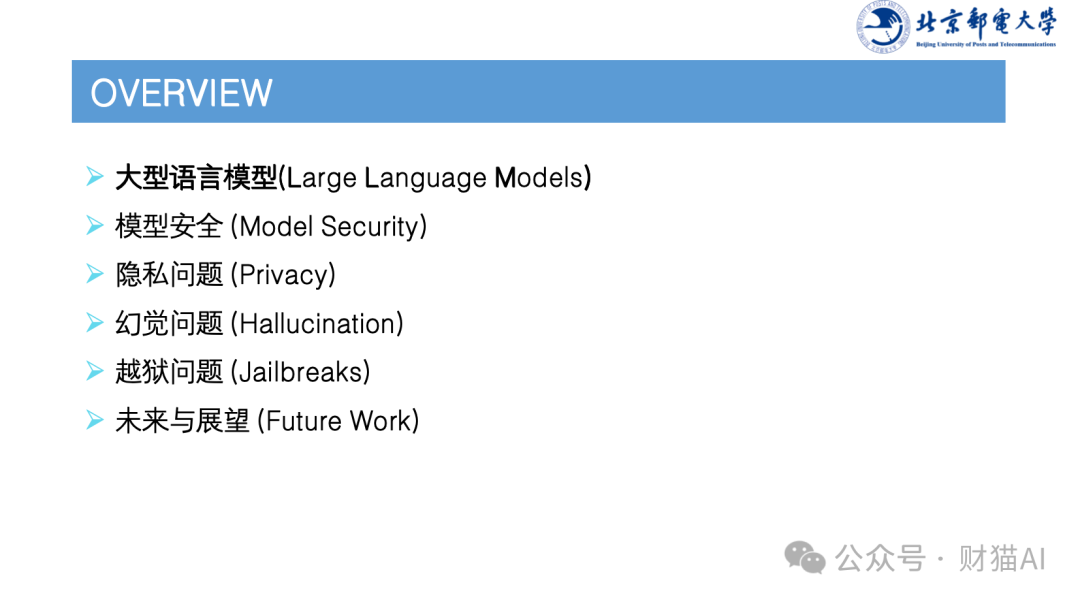

本文主要介绍了大型语言模型(LLM)的安全性研究。首先,作者解释了LLM的发展历程,包括BERT、T5和ChatGPT等模型的演变。接着,文章讨论了大模型的安全性挑战,如数据过滤、对齐(指令微调)和强化学习等方法来提高模型的安全性。此外,文章还提到了隐私泄露问题,包括记忆隐私泄露、系统隐私泄露和上下文隐私泄露。然后,文章分析了幻觉问题的原因和解决方法。最后,文章讨论了越狱攻击的类型和防御措施,并展望了AI安全性的未来发展。

原文信息

【原文链接】 阅读原文

【原文字数】 3375

【阅读时长】 12分钟

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...