中文OCR超越GPT-4V,参数量仅2B,面壁小钢炮拿出了第二弹

文章摘要

【关 键 词】 面壁智能、大语言模型、技术创新、多模态、高效训练

面壁智能,一家源自清华大学的创业公司,近期在大语言模型领域取得了显著进展。该公司致力于优化语言模型,以提高效率并降低成本。今年2月,面壁智能发布了第一代MiniCPM,一款端侧大模型,其性能超越了多个业内标杆,包括Google的Gemma 2B和LLaMa2-13B等。仅70天后,该公司推出了MiniCPM的第二代产品,具备多模态、长文本和MoE(混合专家模型)等领域的迭代能力。

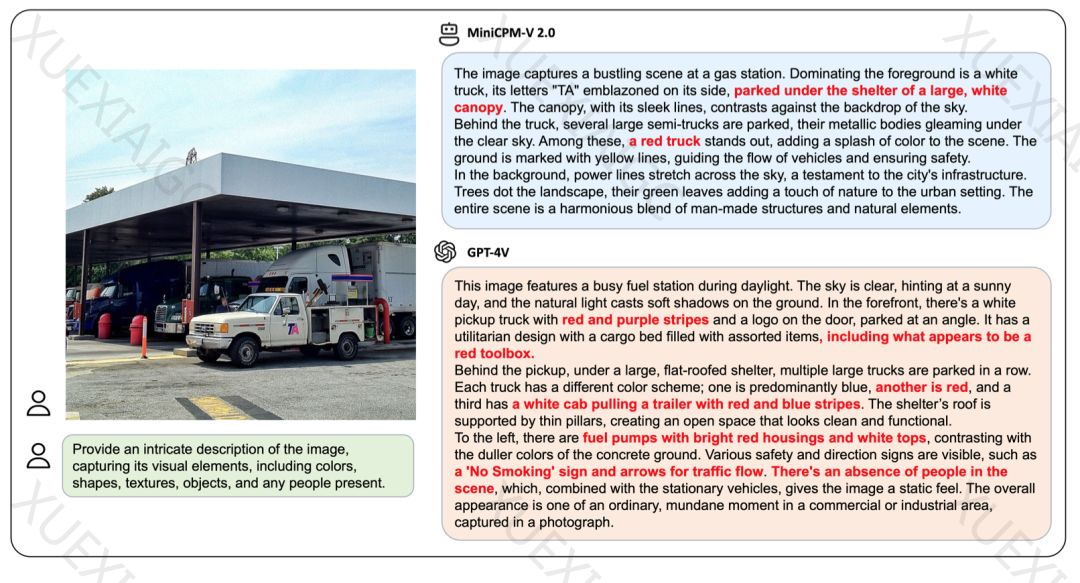

新一代MiniCPM系列模型包括四个版本:MiniCPM-V 2.0、MiniCPM-1.2B、MiniCPM-2B-128K和MiniCPM-MoE-8x2B。MiniCPM-V 2.0是一款多模态模型,参数规模为2.8B,但其性能超越了参数更大的竞品模型。在OpenCompass榜单中,MiniCPM-V 2.0的通用多模态能力超越了其他主流模型。此外,该模型在OCR能力上表现出色,能够精准识别图片中的物体和文字符号,包括古文字。

MiniCPM-1.2B是一款更小型的模型,参数减少了一半,但仍保留了87%的综合性能。在多个公开权威评测榜单上,MiniCPM-1.2B的性能超越了其他更大体量的模型。该模型的内存用量比前一代减少了51.9%,成本下降了60%,更适合在端侧设备上部署和运行。

MiniCPM-2B-128K是一款支持128K上下文窗口的长文本模型,其性能超越了其他6B、7B量级模型。MiniCPM-MoE-8x2B模型则采用了MoE架构,性能提升了4.5个百分点,训练成本降低。

面壁智能的技术实力得益于其在多模态、长文本和MoE架构方面的创新。例如,MiniCPM-V 2.0采用了LLaVA-UHD技术,能够处理高清大图和任意宽高比的图片。此外,该公司还开发了跨语言多模态泛化技术,使模型能够处理不同语言的数据。

面壁智能的研究成果不仅在技术上取得了突破,还对大模型的发展方向提供了新的思考。该公司遵循的Scaling Law表明,在增加模型体量、数据集大小和训练算力的同时,语言建模的性能会提高。然而,面壁智能认为,提升模型效果并不一定需要扩大参数量规模和增加算力成本。相反,让每个参数发挥最大作用,实现更高的性能,才是解决大模型效率问题的核心。

面壁智能的科研团队由100余人组成,80%来自清华北大,平均年龄28岁。该公司已经完成了新一轮数亿元人民币的融资,将用于推动大模型的高效训练和应用落地。通过MiniCPM系列模型等工作,面壁智能为实现AGI的通用基座大模型奠定了基础。

原文和模型

【原文链接】 阅读原文 [ 4171字 | 17分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★