万字探讨:国内AI应用创业陷入恶性循环,问题在哪里,出路是什么?

文章摘要

【关 键 词】 LLM应用、资金短缺、技术创新、逻辑推理、数据系统

自ChatGPT引领的大型语言模型(LLM)发展以来,其对人类社会的深远影响已成为共识。在行业巨头和资本的推动下,LLM及其应用如聊天机器人、多代理系统、多模态对话和人形机器人等迅速发展。2023年,随着基础模型投资的兴起,国内基础模型和清华系获得了大量资源。然而,到了2024年,尽管名义上重视应用层面,但由于外部环境恶劣、商业化路径不清晰、判断力和资金短缺,资本对国内大模型应用的投资变得谨慎,导致投资机会稀缺。

资金不足导致大量套壳应用的出现,反映出资金不足的现状。这导致了一种恶性循环:大模型的缺陷使其无法应用于高价值场景,只能用于低价值对话;缺乏底层技术创新导致产品无法盈利,形成不了竞争壁垒;低价值应用泛滥和过度让利导致用户认为这些服务应该是免费的,可有可无;收入减少迫使运营成本降低,模型压缩导致性能下降,用户流失;用户减少进一步减少资本对应用的投资。

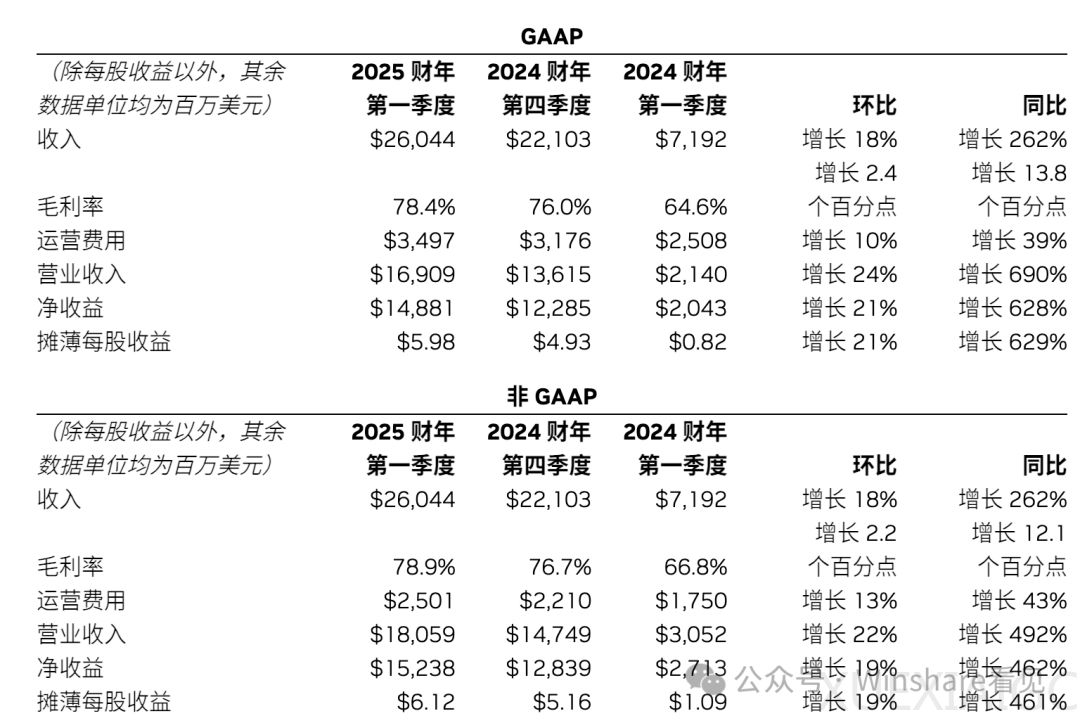

2024年秋天,大环境的冷却和小环境的恶性循环迫使人们重新审视问题所在。英伟达(NVIDIA)的过度依赖在各个领域显现,其CUDA技术的持续迭代定义了无数标准和最佳实践,形成了难以逾越的护城河。英伟达的季度收入和数据中心收入均创下纪录,公司宣布拆股计划并提高现金分红。然而,上游垄断对市场通常不是好事,英伟达的强大和垄断几乎没有为下游留下商业空间。

在不同场景下,大模型的应用面临不同程度的问题。从马斯洛需求层次理论来看,大模型在满足基本需求(如生理和安全)和自我实现需求方面都存在挑战。基本需求市场规模大,技术门槛相对较低,而自我实现需求市场规模有限,技术门槛高。在无法实现边际效应递减的情况下,客单价成为关键指标。大模型商用不应该从低层次需求开始,因为这些需求无法支撑大模型的商业应用。

技术发展的历史上,革命性技术和产品理念在初期往往显得不成熟。例如,iPhone在移动互联网浪潮兴起之前就已经出现,但由于技术限制,体验不佳。直到2006年,电容式触摸屏技术的成熟和低成本化量产改变了一切,为iPhone的诞生提供了条件。乔布斯的产品决策逻辑强调了新技术带来产品定义变化的空间,用户价值变化带来的超额收益增长曲线,以及在技术逐渐收敛的情况下推出最优秀的产品。

当前,大模型应用面临的技术挑战包括确定性和非确定性问题,以及生成准确性问题。高价值场景需要确定性的计算和逻辑推理,而大模型基于概率的过程无法满足这一需求。此外,生成幻觉是大模型一直面临的问题,高价值场景无法容忍错误。为了解决这些问题,需要智能体具备可信的逻辑推导能力、完备的数学抽象和表达能力,以及实时更新知识和无幻觉生成的能力。

学界和业界正在努力解决这些问题。例如,Chain-of-Thought (CoT) 和 Tree-of-Thought (ToT) 提供了自然语言或非完备形式的逻辑分解优化。2023年,姚期智团队发布的累计推理(CR)通过动态存储和利用历史验证的推理结果,克服了CoT和ToT在处理复杂推理任务中的局限性。此外,基于逻辑的形式方法,如SAT/SMT理论,为编程语言理论、数据库理论、人工智能等领域提供了基础。这些方法在硬件和软件验证中起到了核心作用,并被用于解决数学中的未解问题。

数据系统的发展也是关键。RAG和LLM的组合在过去一年被广泛讨论,但现有的RAG在处理全局问题上性能低下。向量数据库作为LLM的触角,需要与模型搭配使用,但其性能并不重要。Graph/KnowledgeGraph因其存在于人类的符号体系内而具有优势,能够进行全局知识推理和抽象。然而,知识图谱的原生结构缺陷可能导致数据暴涨和维护成本增加。

未来,结合向量空间和符号空间的索引系统,支持混合Cypher图查询语言和向量查询,以及传统关系数据库查询,可能会带来巨大的表示形式和数据协同优势。尽管未来仍不明朗,但这些努力为大模型应用的发展提供了希望。

原文和模型

【原文链接】 阅读原文 [ 8754字 | 36分钟 ]

【原文作者】 Founder Park

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★