「还是谷歌好」,离职创业一年,我才发现训练大模型有这么多坑

模型信息

【模型公司】 OpenAI

【模型名称】 gpt-4-0125-preview

【摘要评分】 ★★★★★

文章摘要

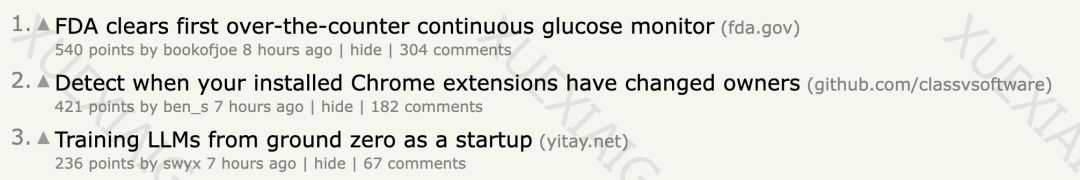

机器之心报道了Yi Tay离开谷歌后创办Reka公司的经历,以及他在构建和训练大型语言模型(LLM)过程中遇到的挑战。Yi Tay分享了从零开始创建一家公司、筹集资金、购买芯片,并追赶Gemini pro/GPT 3.5等LLM的经验。他强调,虽然拥有技术人才和掌握核心算法是关键,但实际工程实践中的挑战也非常重要。

技术挑战主要包括计算资源的稀缺和不可靠,以及与计算提供商打交道的困难。Yi Tay指出,即使是同一种硬件,不同提供商提供的集群质量也有很大差异,这给训练大型模型带来了额外的挑战。他还提到了在多集群设置中建立新环境的困难,以及在谷歌之外使用代码库的挑战。

硬件选择方面,Yi Tay分享了他的个人经验,指出GPU的故障率远高于他在谷歌使用TPU的经历。他认为,这可能更多与管理加速器的硬件团队的能力有关,而不是底层芯片本身。

在工程实践方面,Yi Tay和他的团队开发了许多工具来确保系统的可用性,包括围绕监控、高效检查点和其他优化的工具。他们还安装了自定义文件系统,以实现可扩展的数据存储。此外,Yi Tay提到了在初创公司中,系统地扩展模型的挑战,以及他们如何依赖直觉和本能来快速找到可靠的解决方案。

文章最后,Yi Tay表达了对其他技术创业者的支持,并希望他的经验能够为他人提供有价值的见解。他的故事不仅展示了在技术前沿领域创业的挑战,也强调了在面对困难时持续创新和解决问题的重要性。

原文信息

【原文链接】 阅读原文

【阅读预估】 3576 / 15分钟

【原文作者】 机器之心

【作者简介】 专业的人工智能媒体和产业服务平台

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...