o1带火的CoT到底行不行?新论文引发了论战

文章摘要

【关 键 词】 思维链技术、数学推理、符号推理、性能提升、特定任务

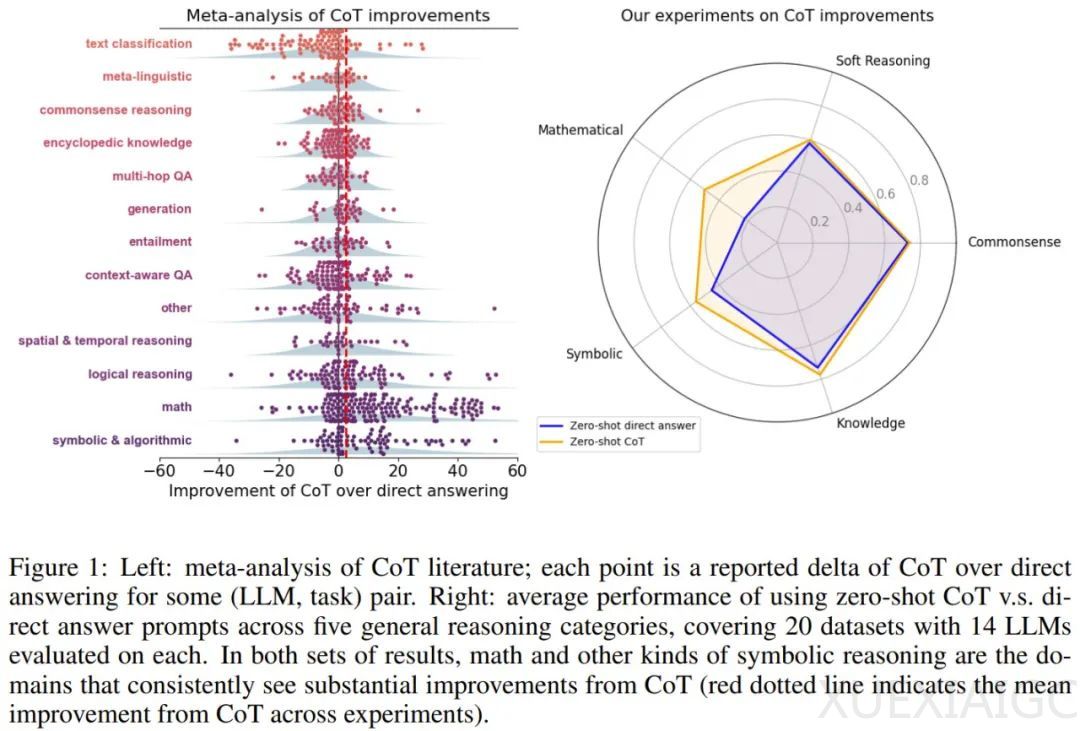

近期,德克萨斯大学奥斯汀分校、约翰·霍普金斯大学和普林斯顿大学的研究人员提出了一个关键问题:在大型语言模型(LLM)中,是否应该使用思维链(Chain-of-Thought, CoT)技术。他们的研究结果表明,CoT技术在解决数学和符号推理任务时表现出显著优势,但在其他类型的任务中,其效果并不明显,甚至可能对模型性能产生负面影响。

研究团队通过分析近期文献和进行实验研究,得出了以下主要发现:

1. CoT技术在数学和符号推理任务中能够显著提升LLM的性能,平均性能提升达到56.9%,而直接回答法的性能为45.5%。然而,在其他任务上,CoT技术的平均性能仅为56.8%,与直接回答法的56.1%相比,提升微乎其微。

2. CoT技术能够帮助LLM生成更有效的计算和符号操作方案,但如果结合外部符号解算器,性能表现会更好。这表明在CoT技术有效的任务上,使用外部工具可能会获得更好的结果。

3. 在零样本和少样本提示设置下,CoT技术在非符号推理类别和数据集上的表现与直接回答法几乎没有区别。但在数学和符号类别上,CoT技术能够带来显著的性能提升。

4. 回答格式对CoT技术的有用性影响不大。在需要不同层级的非符号推理的数据集上,CoT技术的表现与直接回答法相近。

5. 在知识、软推理和常识推理的数据集上,CoT技术带来的提升并不显著,但在MMLU、StrategyQA和MuSR等特定数据集上,CoT技术能够带来显著的增益。

6. CoT技术在形式推理方面的优势主要体现在规划和执行两个阶段。在数学问题中,CoT技术能够显著提升LLM的性能,但在其他类型的任务中,其优势并不明显。

综上所述,CoT技术在特定类型的任务中具有明显优势,但在其他任务中可能并不适用。研究团队建议,对于广泛使用CoT技术解决的问题,可以考虑采用更高效的方法,以降低推理成本并提高性能。同时,他们呼吁开发更复杂精妙的方法,如基于搜索、交互式智能体或针对CoT进行过更好微调的模型,以进一步提升LLM的性能。

原文和模型

【原文链接】 阅读原文 [ 2440字 | 10分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★