文章摘要

【关 键 词】 大模型、评估基准、提示多样性、主题建模、用户查询

该文章介绍了一个专注于AIGC领域的专业社区,关注微软 & OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地的平台。

文章指出,开发一个安全、准确的大模型评估基准需要包含稳定识别模型能力、反映真实世界使用情况中的人类偏好以及经常更新以避免过拟合或测试集泄漏等重要内容。

传统的基准测试通常是静态的或闭源的,而大模型的技术发展和功能迭代的比较凸显了建立具有高可分离性评估基准的必要性。

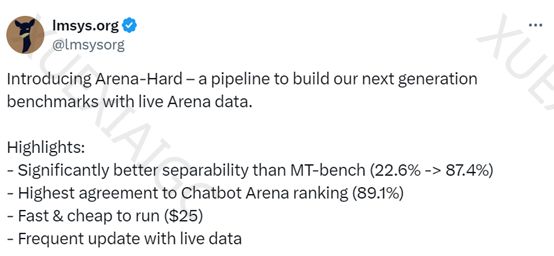

Lmsys组织开源了一个全新高质量大模型评估基准Arena-Hard,与当前领先的聊天大模型基准测试MT Bench进行了比较。

结果显示,Arena Hard v0.1相对于MT Bench提供了更强的可分离性,且置信区间更窄,与Chatbot Arena的人类偏好排名具有更高的一致性。

Arena-hard-v0.1相比广泛采用的大模型基准显示出最高的可分离性,并且便宜且运行速度快。

Arena-hard-v0.1构建了一个管道,可以从通过Chatbot Arena收集的200,000个用户查询的数据集中自动提取高质量提示,包括多样性和提示质量。

为了确保提示多样性,Lmsys采用主题建模管道,在BERTopic中使用主题建模管道,帮助识别涵盖广泛领域的4000多个主题。

为了帮助大模型选择高质量的用户查询,Lmsys开发了一个经过校准的系统提示,根据七个关键标准如特异性、领域知识、问题解决能力等选择高质量的用户查询。

大模型Judge对每个提示进行注释,然后根据提示的平均得分对每个簇进行评分。

最后,Lmsys展示了从低到高平均分数的主题集群示例,例如游戏开发或数学证明。

研究表明高潜在得分与不同模型的胜率之间存在很强的相关性。

原文和模型

【原文链接】 阅读原文 [ 1090字 | 5分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 gpt-3.5-turbo-0125

【摘要评分】 ★☆☆☆☆