Up主已经开始鬼畜,腾讯开源「AniPortrait」让照片唱歌说话

文章摘要

【关 键 词】 开源项目、动画生成、音频驱动、人像动画、腾讯新技术

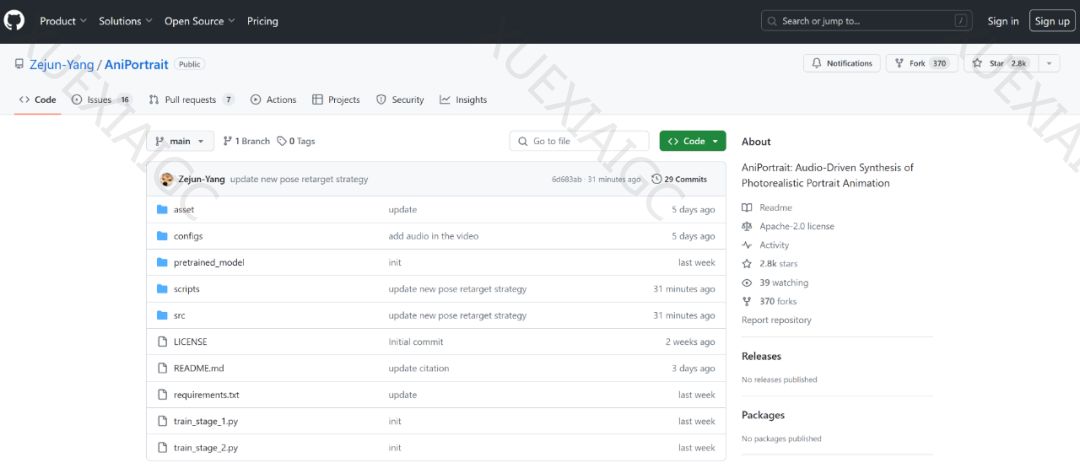

腾讯最近开源了一个名为AniPortrait的新项目,它能够基于音频和一张参考图像生成高质量的动画人像。这个项目迅速在GitHub上获得了超过2800个星标,显示出其受欢迎程度。AniPortrait的核心在于其两个模块:Audio2Lmk和Lmk2Video。Audio2Lmk模块负责从音频中提取面部表情和嘴唇动作的Landmark序列,而Lmk2Video模块则利用这些序列生成时间上稳定一致的高质量人像视频。

在Audio2Lmk模块中,腾讯团队使用了预训练的wav2vec模型来提取音频特征,并通过一个简单的架构将这些特征转换成3D人脸网格。为了将音频转换成姿势序列,团队采用了一个带有transformer解码器的网络,该网络通过交叉注意力机制将音频特征整合进解码器。这些步骤最终产生2D的人脸Landmark序列,为下一阶段的视频生成做准备。

Lmk2Video模块的设计灵感来自AnimateAnyone,它使用了SD1.5作为骨干网络,并整合了一个时间运动模块。此外,该模块还包括一个ReferenceNet,用于提取参考图像的外观信息。与AnimateAnyone不同的是,AniPortrait在PoseGuider的设计上进行了改进,采用了多尺度策略来捕获嘴唇的复杂运动,并引入了参考图像的Landmark作为额外输入,以提高动作生成的精确度。

在实验部分,Audio2Lmk阶段使用的是wav2vec2.0网络,而3D网格和姿势的提取工具是MediaPipe。训练数据来自腾讯的内部数据集,包含了接近一个小时的高质量语音数据。Lmk2Video过程采用了两步式训练方法,使用了VFHQ和CelebV-HQ两个大规模高质量人脸视频数据集。实验结果显示,AniPortrait生成的动画在质量和真实度上都非常出色,用户还可以编辑中间的3D表征,从而对最终输出进行修改。

AniPortrait的开源发布为动画制作和虚拟人像生成领域带来了新的可能性,尤其是对于那些需要快速生成高质量人像视频的应用场景。这项技术的开放性和高效性可能会在未来的内容创作和娱乐产业中发挥重要作用。更多细节和技术实现可以参考原论文。

原文和模型

【原文链接】 阅读原文 [ 1587字 | 7分钟 ]

【原文作者】 机器之心

【摘要模型】 gpt-4

【摘要评分】 ★★★☆☆