Sora之后,苹果发布视频生成大模型STIV,87亿参数一统T2V、TI2V任务

文章摘要

【关 键 词】 视频生成、多模态、AI模型、PixArt-Alpha、文本图像

苹果公司的研究团队最近发布了一项关于视频生成大模型的新研究,名为STIV(Scalable Text and Image Conditioned Video Generation)。这项研究提出了一个具有87亿参数的多模态视频生成模型,能够处理文本和图像条件。STIV模型基于PixArt-Alpha架构,通过变分自编码器(VAE)和Diffusion Transformer(DiT)块处理输入帧,同时结合T5分词器和CLIP文本编码器处理文本输入。研究中还包括了时空注意力分解、条件嵌入、旋转位置编码(RoPE)和流匹配目标等优化,以提升模型性能。

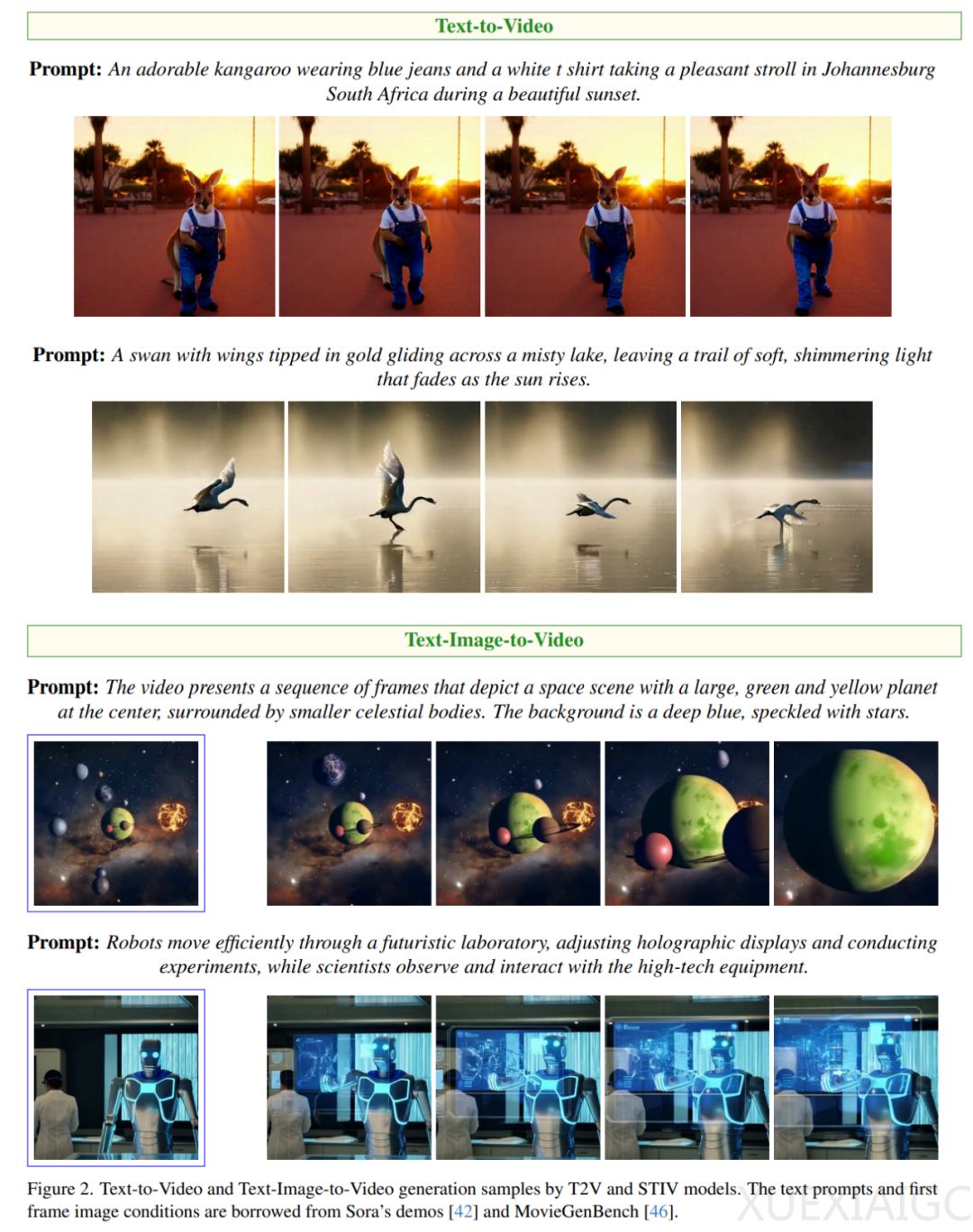

STIV模型的主要贡献在于统一处理文本到视频(T2V)和文本-图像到视频(TI2V)任务,并显著提升生成质量。研究还涉及了架构设计、训练技术和渐进式训练策略,使模型易于训练且适配性强,可扩展至视频预测、帧插值和长视频生成等任务。实验结果显示STIV在VBench基准数据集上的优势,包括详细的消融实验和对比分析。

在模型构建方面,STIV采用了多种优化策略,包括稳定训练策略和高效训练改进,以支持大规模模型训练。图像条件融合方法包括帧替换策略和图像条件随机丢弃,以及联合图像-文本无分类器引导(JIT-CFG),以提升生成质量。渐进式训练策略则通过逐步训练T2I、T2V和STIV模型,以适应高分辨率和长时训练。

数据预处理和特征提取方面,研究团队解决了原始视频中的不一致动作和不必要过渡问题,并提取了包括运动分数、美学分数等在内的初始特征。视频字幕生成与分类细节方面,研究引入了视频字幕生成模块,以生成全面的文本描述,并开发了DSG-Video评估模块,以评估字幕的丰富度和准确性。

实验结果表明,STIV模型在视频生成质量上取得了显著提升,并为视频生成模型在未来多种应用场景中的推广奠定了基础。模型从600M参数扩展到8.7B,并在VBench基准数据集上展示了优势。此外,STIV模型还在视频预测、帧插值和多视角生成等任务中表现出色。更多细节和实验结果可以在原论文中找到。

原文和模型

【原文链接】 阅读原文 [ 4159字 | 17分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★