文章摘要

【关 键 词】 深度学习、Scaling Law、泛化误差、模型精度、数据规模

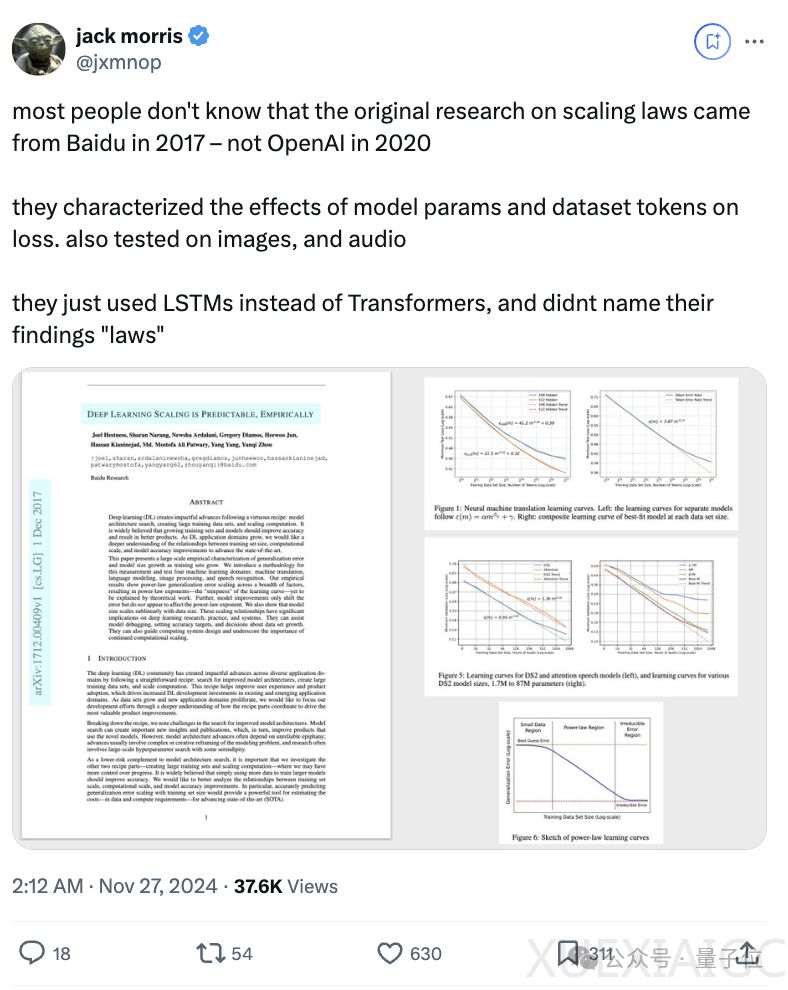

在深度学习领域,Scaling Law的概念最早由百度在2017年提出,而非后来的OpenAI。这项研究由吴恩达领导的百度硅谷人工智能实验室(SVAIL)系统团队进行,探讨了训练集大小、计算规模和模型精度之间的关系。通过大规模实证研究,团队发现泛化误差与训练集大小呈幂律关系,即随着训练集的增大,泛化误差会以一定的幂次下降。同时,模型大小与数据大小也存在缩放关系,模型大小的增长速度通常比数据大小的增长速度慢。

研究涉及机器翻译、语言建模、图像分类和语音识别等多个领域。在机器翻译中,随着训练集规模的增大,优化变得更加困难,模型会出现容量不足的情况。在词语言模型中,最佳拟合模型随训练分片大小呈次线性增长。字符级语言建模通过训练深度为10的循环高速公路网络(RHN)在十亿单词数据集上达到最先进的准确率。图像分类呈现出幂律学习曲线和模型大小的缩放关系,而在非常小的训练集上,准确率会在接近随机猜测的水平上趋于平稳。语音识别中,随着数据量的增加,大多数模型会经历幂律泛化改进,直至数据量接近其有效容量。

这项研究对深度学习的研究、实践和系统都有重要影响,可以帮助模型调试、设定准确度目标和数据集增长决策,指导计算系统设计,并强调持续计算扩展的重要性。当时的合著者们已经各自去到各个机构实验室、大厂继续从事大模型相关的研究。Anthropic CEO Dario Amodei 在百度研究院吴恩达团队工作过,他对Scaling Law的第一印象也是那时研究语音模型产生的。

原文和模型

【原文链接】 阅读原文 [ 1688字 | 7分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...