文章摘要

【关 键 词】 AI模型、性能测试、GPQA、错误消息、公众期待

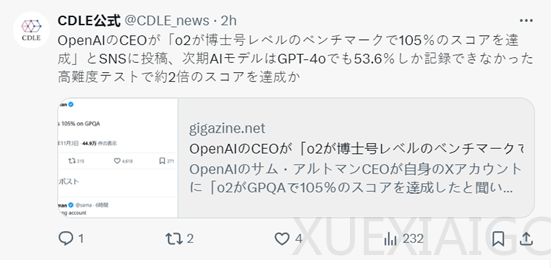

OpenAI首席执行官Sam Altman发布了一条关于o2模型在GPQA性能测试中达到105%的消息,这一数据远超过人类博士级专家的平均准确率65%和普通人的34%,甚至超过了o1模型的78%。然而,这一消息随后被Sam本人纠正为账号错误,他本人对此表示自嘲,并认为这是一种好的生活方式。尽管如此,关于o2模型的消息引起了广泛关注和讨论,许多人对模型的性能表示期待,甚至有人误以为消息为真,提出了对新模型的期待和对现有标准的重新思考。

GPQA是一个难度极高的测试数据集,由各领域专家编写,涵盖生物、物理和化学三大学科,包括高能粒子物理、凝聚态物理、相对论力学、遗传学、无机化学等子分类。问题设计复杂,经过专家审核和反馈修订,最终由其他领域的三位专家回答以验证问题准确性和客观性。GPQA公布的测试数据显示,人类博士级专家的回答平均准确率为65%,普通人只有34%,而o1模型是唯一超过人类博士准确率的AI模型,达到了78%。

Sam Altman的这一错误消息虽然被纠正,但其传播效应和引起的讨论显示了他在营销方面的才能,即使是错误的消息也能引发广泛关注。同时,这也反映了人们对AI模型性能的期待和对现有测试标准的挑战。

原文和模型

【原文链接】 阅读原文 [ 1179字 | 5分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★☆☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...