SFT在帮倒忙?新研究:直接进行强化学习,模型多模态推理上限更高

文章摘要

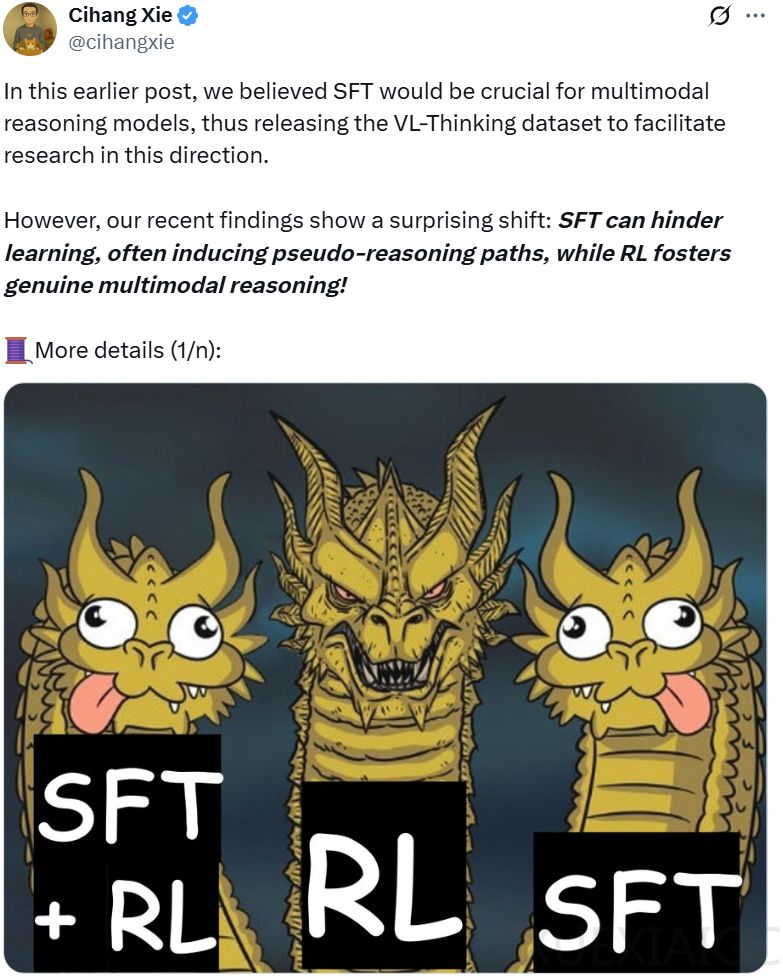

随着OpenAI的o1/o3和Deepseek-R1等具备强大推理能力的大语言模型相继问世,学界普遍采用「监督微调 + 强化学习」的两阶段训练范式。这种范式在纯文本领域取得了显著成功,并启发研究人员将其优势拓展到视觉-语言大模型(LVLM)领域。然而,加州大学圣克鲁兹分校和德克萨斯大学达拉斯分校等机构的研究团队近日发现,监督微调(SFT)可能会阻碍学习,导致伪推理路径的出现,而强化学习(RL)则能促进真正的多模态推理。

为系统性地研究SFT与RL在视觉语言模型开发中的适用性,研究者构建了首个支持SFT与RL的全方位高质量图文推理数据集VLAA-Thinking。该数据集包含基于R1模型「先思考后回答」范式生成的完整推理链条,其中SFT分支包含适合视觉指令调优的多模态思维链(CoT)样本,强化学习分支则从同源数据中筛选更具挑战性的样本以激发深度推理行为。研究者设计了六阶段数据处理流程,包括元数据收集、图像描述生成、基于R1的知识蒸馏、答案重写、人工验证和数据划分,最终形成高质量的SFT与RL训练数据。

研究者在GRPO框架中创新性地设计了融合感知与认知奖励的混合奖励函数,包含2大类5种子函数,用于规则类和开放类问题的评分。通过广泛的实验比较,他们发现SFT虽能提高模型在标准任务中的性能,但在增强复杂推理方面能力却有所欠缺,甚至会导致伪推理路径的出现。具体而言,SFT模仿的推理模式会阻碍真正的推理进步,在7B模型上相对性能下降47%。此外,消融分析表明,对于基于规则的奖励,数学和多选题比其他奖励更有益,而基于规则和开放式奖励的结合则能得到最佳性能。

研究还发现,如果对已对齐的模型使用SFT+GRPO,会导致平均12.7%的性能下降,且模型规模差异影响甚微。训练过程分析表明,响应长度、奖励分数与性能表现无显著相关性。尽管经SFT的模型能获得更高初始奖励和更长响应,但实际表现逊于纯RL训练模型,这与「更优模型通常产生更长响应」的既有结论相悖。研究表明,SFT虽可帮助未对齐模型遵循指令,但其倡导的模仿式推理会限制RL阶段的探索空间;相比之下,直接从奖励信号学习能产生更有效的适应性思维。

研究者提出的纯RL方案在实验中表现出色,训练得到的VLAA-Thinker-Qwen2.5VL-3B模型在Open LMM推理榜单4B量级模型中位列第一,以1.8%优势刷新纪录。案例分析表明,该模型生成的推理轨迹更简洁有效。为进一步提升多模态推理能力,研究者将GRPO训练应用于视觉语言推理任务,并提出了一个混合奖励框架,涵盖视觉感知和视觉推理任务。

综合这些结果,可以得出结论:在多模态推理的背景下,SFT目前与GRPO不兼容,会损害基础模型和经过指令调优的LVLM的性能。研究者还发现,较小的SFT数据集仍然会影响GRPO的性能,且回应长度和奖励并不是推理能力的可靠指标。这些趋势进一步揭示,SFT仅提供了RL训练的一个更高的「下限」,但它可能会降低「上限」,因为推理相关的SFT数据限制了模型的探索路径。因此,推理是一种内生的、更可能通过强化学习而非SFT发展起来的能力。

研究者直接进行了GRPO训练,生成了四个模型,并在Qwen2-VL-7B的基础模型上进行了训练。评估结果表明,直接使用GRPO训练的模型在视觉语言推理任务中显著优于其基础模型,且经过更好指令调优的模型在GRPO训练后表现更佳。GRPO训练能够诱导模型产生真实的自我反思行为,但「aha」时刻的数量与整体推理性能并不直接相关。这些发现为未来视觉语言模型的训练范式提供了新的思路和方向。

原文和模型

【原文链接】 阅读原文 [ 2615字 | 11分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★