文章摘要

【关 键 词】 AI Copilot、效率提升、RAG技术、信息检索、性能反馈

Uber最近分享了其开发Genie的经历,Genie是一款AI驱动的随时待命的Copilot,旨在提高随时待命的支持工程师的效率。自2023年9月推出以来,Genie在154个Slack频道中回答了超过70,000个问题,节省了大约13,000个工程小时,用户评估的有效回答率为48.9%。Genie利用检索增强生成(RAG)技术提供准确的实时响应,显著提高事件响应的速度和效率。

Uber的待命工程师通常花费大量时间答复重复的查询或浏览零散的文档,使用户难以独立找到答案。这些情况导致了响应时间过长和生产力下降,这也是构建Genie的驱动力。Uber使用RAG来驱动Genie,RAG是一种创新方法,它将信息检索系统的优势与生成式AI模型相结合,以产生准确且相关的响应。它让Uber可以利用现有知识来源快速部署解决方案,这样就用不着AI模型微调所需的大量示例数据了。

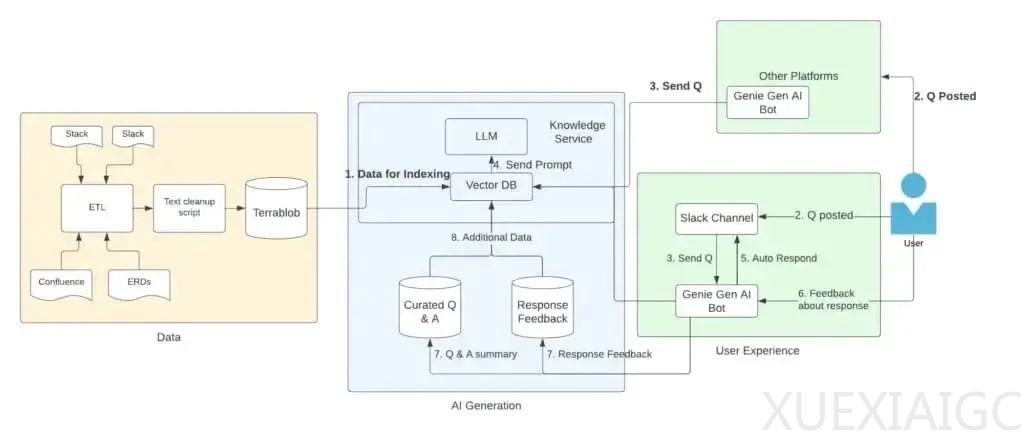

Genie从各种内部来源提取数据,例如Uber的wiki、Stack Overflow和工程文档。信息被抓取后,使用OpenAI模型转换为向量嵌入,并存储在Uber的内部向量数据库Search In Action(SIA)中。Genie仅从预先批准的数据源提取数据,且不包含敏感数据,以避免泄露敏感信息。

当用户在Slack中提出问题时,查询会被转换为嵌入,Genie会使用该嵌入在向量数据库中获取上下文相似的数据。然后它将这些数据输入到大型语言模型中,以根据检索到的信息生成准确的响应。Uber实施了一个指标框架,通过持续的实时用户反馈来提高Genie的性能。在Genie回答问题后,用户可以通过选择“已解决”、“有帮助”或“不相关”等选项来提供反馈。

这些反馈通过Slack插件收集,并使用Uber的内部数据流系统处理,将指标发送到Hive表中分析。反馈循环允许Uber的团队跟踪Genie的帮助有效率,并根据真实的用户体验改进其响应。对于性能评估,Uber设计了一个自定义评估管道,用于评估各种指标,例如幻觉率和响应的相关性。该管道处理的是历史数据,包括Slack元数据、用户反馈和Genie以前的响应。它通过由LLM支持的评分系统来处理这些数据,用这个系统充当评判者。

Uber还采用了一套文档评估流程,以保障Genie在其响应中检索和使用的信息的质量。系统将抓取的知识库转换为结构化格式,其中一行代表一个文档。Genie将这些文档输入带有自定义评估提示的LLM来评估每个文档的清晰度、准确性和实用性。然后,LLM返回分数并提供改进每个文档的可行建议。此过程有助于保持底层文档的高标准,确保Genie的响应保持可靠和有效。

原文和模型

【原文链接】 阅读原文 [ 1064字 | 5分钟 ]

【原文作者】 AI前线

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆