文章摘要

【关 键 词】 AI进步、预训练、Scaling Law、推理计算、未来AI

在最近举行的NeurIPS会议上,OpenAI的核心成员Noam Brown提出了关于预训练终结和Scaling Law的讨论,引发了广泛关注。Brown指出,从2019年至今,AI领域的巨大进步主要归功于数据和算力规模的扩大,但大语言模型在解决简单问题上仍存在困难。他提出疑问,是否需要继续投入更高成本来训练更好的AI。

Brown回顾了AI模型在扩展过程中的规律,如2012至2015年间扑克模型的扩展,以及在棋牌游戏中扩展推理的历史。他引用了Andy L. Jones关于游戏Scaling Laws的图表,提出用10倍的预训练计算量可以换取15倍的测试时间计算量。他预测,o1将带来更高推理计算能力的Scaling。

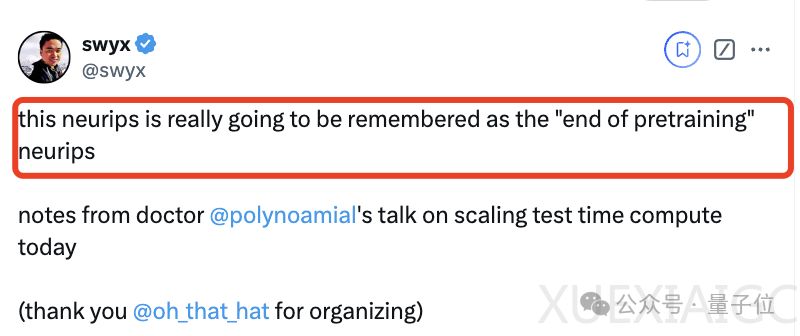

网友评论中,有人提到预训练时代可能即将终结,这对英伟达等公司可能不是好消息。但也有从业者反对这种看法,认为推理时间计算并不新鲜,而且减少面向用户的推理时间计算是一个深思熟虑的选择。Ilya在讨论未来超级智能时也提到,推理越多,系统变得越不可预测,尤其是在复杂任务中。

总的来说,Noam Brown在NeurIPS会议上的演讲引发了关于预训练和Scaling Law的热烈讨论。他提出,o1将带来更高推理计算能力的Scaling,而未来AI的发展将更加不可预测。这一讨论也反映了AI领域对于预训练和Scaling Law的持续关注和探索。

原文和模型

【原文链接】 阅读原文 [ 1121字 | 5分钟 ]

【原文作者】 量子位

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★☆☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...