OpenAI、谷歌等一线大模型科学家公开课,斯坦福CS 25春季上新!

文章摘要

【关 键 词】 Transformer、深度学习、课程、研究、AI

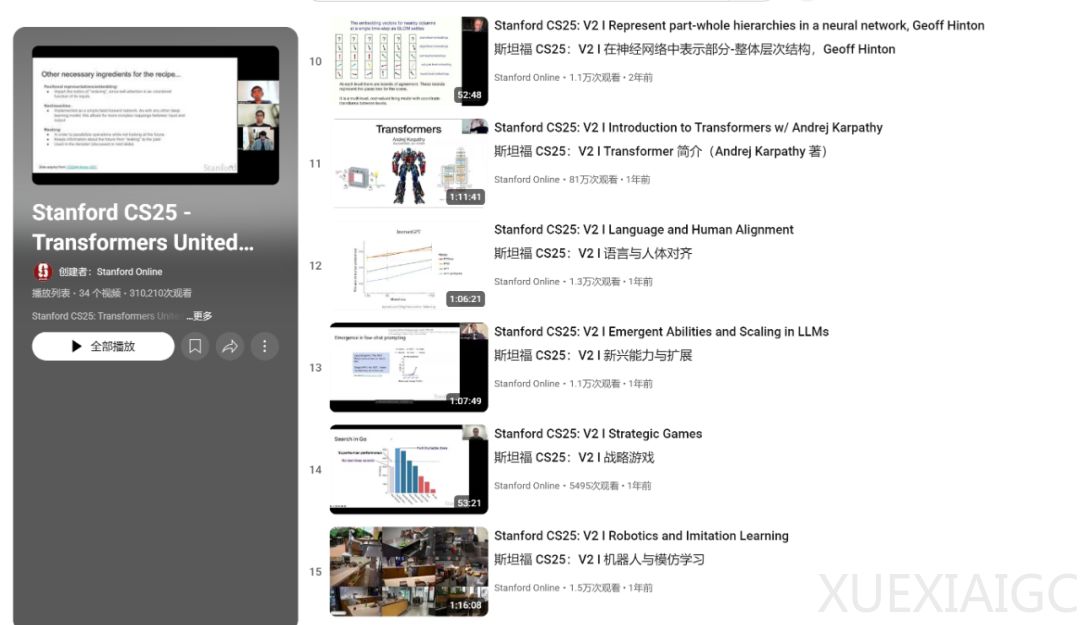

斯坦福大学的CS25课程专注于Transformer架构,吸引了众多AI领域的顶尖研究者参与。这门课程的最新版本「CS25: Transformers United V5」邀请了Google DeepMind、OpenAI和Meta等机构的知名科学家,深入探讨AI领域的最新进展。课程完全开放,任何人都可以现场旁听或通过Zoom观看直播,无需注册或与斯坦福大学建立关联。课程结束后,视频会上传到官方YouTube频道,供更多人学习。

往期课程中,Geoffrey Hinton分享了他在神经网络中部分-整体层次结构的最新研究,提出了GLOM模型,旨在模拟人类视觉系统处理复杂场景的能力。GLOM通过动态解析树结构增强Transformer在视觉任务中的表现,解决了自注意力机制的计算效率瓶颈。Andrej Karpathy则系统介绍了Transformer架构的原理与影响,从自注意力机制到多头注意力,再到Transformer在大型语言模型中的核心作用,并展望了模型高效化和多模态学习的未来。

Douwe Kiela深入探讨了检索增强生成(RAG)技术,作为解决大型语言模型局限性的关键。RAG通过外部检索器提供上下文信息,缓解了幻觉、信息时效性和定制化问题。他还回顾了语言模型的历史,并调研了RAG的最新进展,如Realm、Atlas和Retro架构,分析了其优劣。

OpenAI的Jason Wei和Hyung Won Chung分享了关于大型语言模型和Transformer架构的洞见。Jason Wei强调下一词预测作为大规模多任务学习的本质,并分析了扩展律与个体任务的涌现能力。Hyung Won Chung则从历史视角审视Transformer架构的演变,聚焦计算成本指数下降的驱动作用,提出通过连接过去与现在预测AI未来的统一视角。

这些课程不仅展示了Transformer架构在AI领域的广泛应用,还探讨了其未来发展的潜力。通过邀请顶尖研究者分享最新研究成果,CS25课程为AI社区提供了宝贵的学习资源,推动了AI技术的进步。

原文和模型

【原文链接】 阅读原文 [ 1104字 | 5分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★☆☆☆