MoE 高效训练的 A/B 面:与魔鬼做交易,用「显存」换「性能」

文章摘要

【关 键 词】 MoE技术、稀疏激活、算力节约、模型训练、实用价值

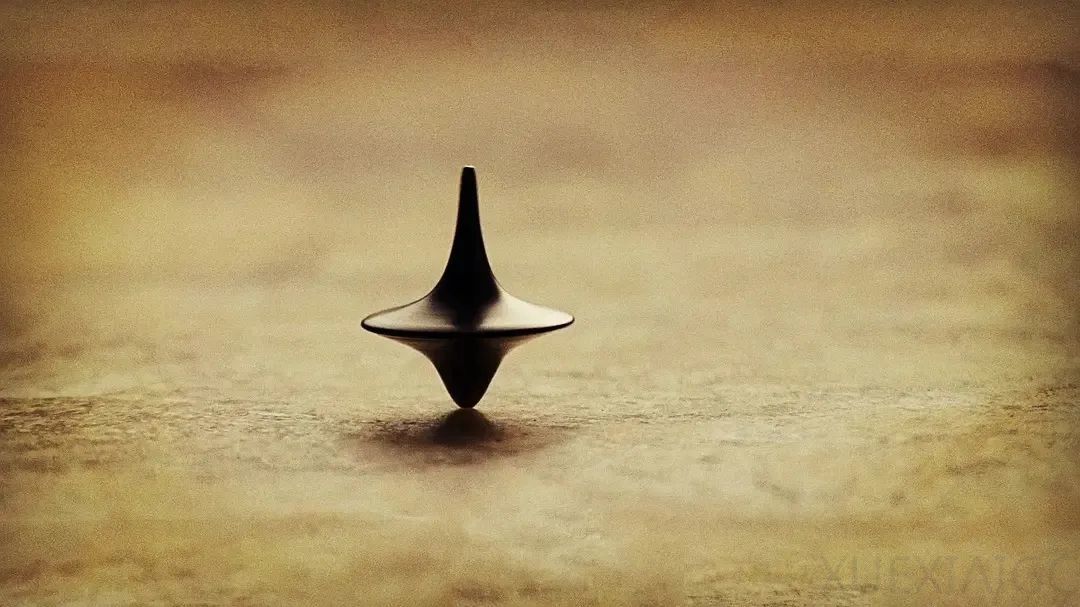

本文介绍了MoE(混合专家)作为一种模块化的稀疏激活技术在大型模型训练中的应用。MoE通过将模型参数划分为多个专家子模块,每个输入仅激活少数相关专家,从而降低计算量。随着模型规模增大,MoE技术在算力有限的情况下成为必然选择。业内已出现多个基于MoE架构的大模型,但在专家数量、激活机制等方面仍有分歧。MoE的优势在于算力节约,但存在存储消耗大、训练复杂等问题。尽管如此,MoE被视为一种妥协的艺术,在算力稀缺的当下具有实用价值。未来,随着技术发展,MoE有望继续优化和扩展。

原文和模型

【原文链接】 阅读原文 [ 5189字 | 21分钟 ]

【原文作者】 AI科技评论

【摘要模型】 glm-4

【摘要评分】 ★☆☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...