文章摘要

【关 键 词】 多模态、大语言模型、边缘设备、图像推理、开源

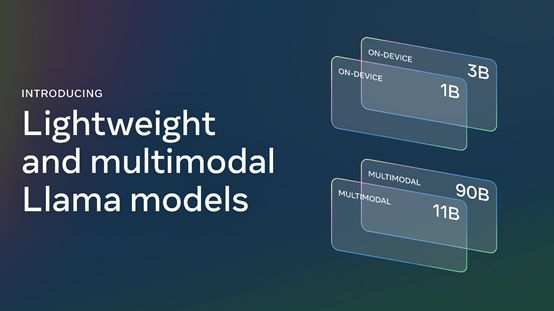

Meta公司最近发布了其首个多模态大语言模型(LLM)Llama-3.2,标志着Llama系列的重大升级。此次升级包括四个不同规模的模型,旨在满足不同应用场景的需求。

Llama 3.2的1B和3B版本是该系列中最轻量级的模型,专为边缘设备和移动应用程序设计,如个人信息管理和多语言知识检索。这些模型支持长达128k标记的上下文长度,并且已经针对高通和联发科的硬件进行了适配,以及对Arm处理器进行了优化,这将有助于它们在各种移动和物联网设备中的快速应用。

此外,11B和90B版本是Llama系列首次推出的多模态大模型,它们能够理解并推理图像,执行文档分析、图像字幕和视觉问答等任务。90B版本特别擅长于常识、长文本生成、多语言翻译、编码、数学和高级推理,同时引入了图像推理功能,能够处理图像标题生成、图像文本检索、视觉基础、视觉问题解答和视觉推理,以及文档视觉问题解答等任务。

11B版本则更适合内容创建、对话式人工智能、语言理解和需要视觉推理的企业应用。它在文本摘要、情感分析、代码生成和执行指令方面表现出色,并同样增加了图像推理能力,其应用场景与90B版本相似。

测试数据表明,Llama 3.2模型在图像识别和视觉理解基准测试中的表现与市场上领先的闭源模型相媲美,例如Claude 3 haiku等。这表明Llama 3.2在多模态任务上具有强大的竞争力。

开源地址为:https://www.llama.com/?utm_source=twitter&utm_medium=organic_social&utm_content=video&utm_campaign=llama32,感兴趣的开发者和研究人员可以访问该网站了解更多信息和下载模型。

原文和模型

【原文链接】 阅读原文 [ 529字 | 3分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★☆☆☆☆