模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

【摘要评分】 ★★★★★

文章摘要

【关 键 词】 Chat with MLX、苹果电脑、大模型、本地部署、AI

Chat with MLX是一个新框架,允许Mac用户在本地运行大型机器学习模型,类似于N卡用户的Chat with RTX。这个框架由一名前OpenAI员工开发,支持11种语言和7种开源大模型。用户可以通过简单的pip命令安装,并在终端中启动。Chat with MLX不仅支持本地文档总结和YouTube视频分析,还可以使用自有数据进行索引。尽管在苹果设备上运行可能会对计算量造成较大负担,但用户体验仍然积极。测试表明,模型在M1芯片的MacBook上表现流畅,尤其是在不使用定制数据时。Chat with MLX的本地RAG检索功能是其主要卖点,尽管速度略慢于纯生成。开发者还在GitHub上积极回应用户反馈,更新程序。总的来说,Chat with MLX的推出标志着本地化、专属化大模型向消费级产品的普及趋势。

摘要总结

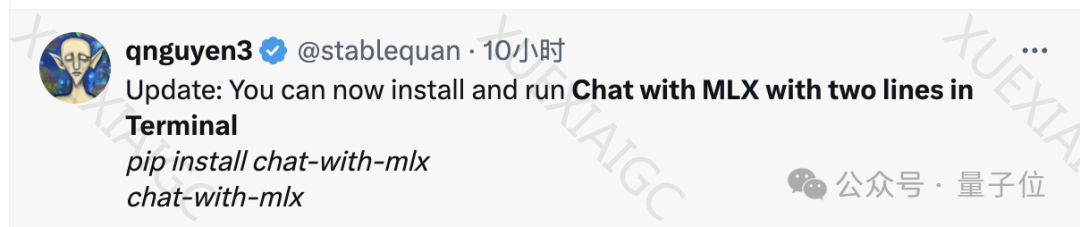

Chat with MLX 是一个新推出的框架,它使得Mac用户也能够在本地运行大型机器学习模型,类似于N卡用户使用的Chat with RTX。这个框架由一名OpenAI的前员工开发,它支持包括中文在内的11种语言,并自带7种开源大模型。用户可以通过简单的pip命令安装Chat with MLX,并在终端中启动它。这个框架不仅能够进行本地文档总结和YouTube视频分析,还能够使用用户自有的数据进行索引。

在实际测试中,Chat with MLX在M1芯片的MacBook上表现出了流畅的性能,尤其是在不使用定制数据的情况下。尽管如此,由于计算量较大,它在速度上可能无法与英伟达的Chat with RTX相媲美。此外,Chat with MLX的本地RAG检索功能是其主要卖点,尽管在测试中发现速度略慢,并且有时会出现提示词被吐出的情况。

开发者在GitHub上积极回应用户的反馈,并更新了程序。Chat with MLX的推出显示了本地化、专属化大模型向消费级产品普及的趋势。对于那些关心数据安全性的用户来说,这是一个值得考虑的选择。GitHub上的项目地址为:[Chat with MLX GitHub](https://github.com/qnguyen3/chat-with-mlx)。

原文信息

【原文链接】 阅读原文

【阅读预估】 1125 / 5分钟

【原文作者】 量子位

【作者简介】 追踪人工智能新趋势,关注科技行业新突破