文章摘要

【关 键 词】 语言模型、思维缓冲区、推理任务、BoT方法、性能提升

北大、UC伯克利和斯坦福的研究人员针对大型语言模型(LLM)在推理任务上的不足,提出了一种名为“思维缓冲区”(Buffer of Thoughts,简称BoT)的新方法。该方法通过创建一个元缓冲区来存储信息丰富的高级思维,即“思维模板”,从而提升LLM在推理密集型任务上的表现。

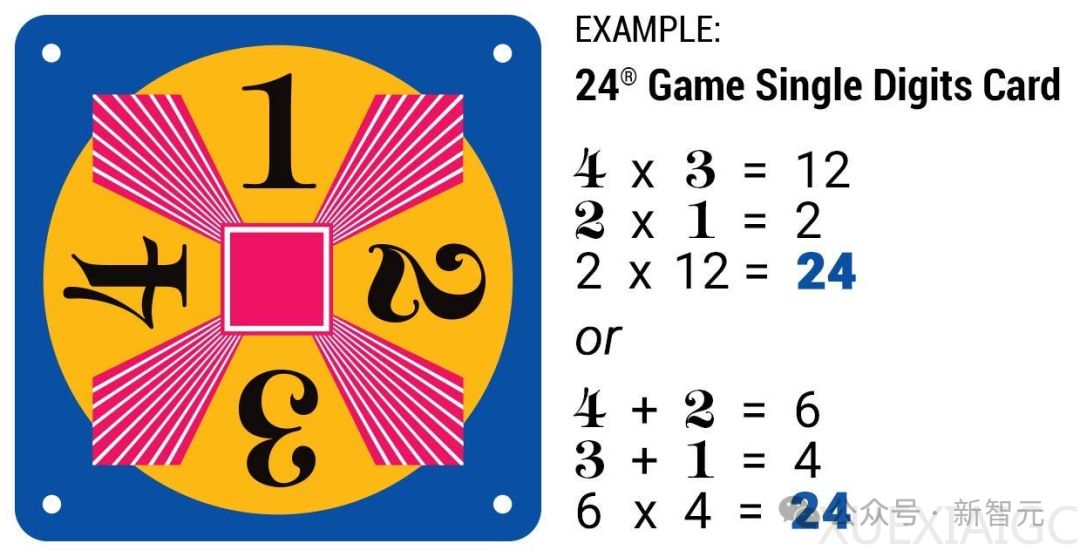

在24点游戏、几何图形任务和一步将死问题等推理任务中,BoT方法显著提高了LLM的性能,分别提升了11%、20%和50%。此外,即便是较小规模的Llama3-8B模型,在BoT的辅助下也能在某些任务上超越更大规模的Llama3-70B模型。

BoT方法主要有三个优势:准确性、推理效率和鲁棒性。准确性体现在通过共享思维模板,LLM能实例化高级思维解决不同问题,而无需从头构建推理结构;推理效率得益于LLM能直接利用历史推理结构进行推理,避免复杂的多查询过程;鲁棒性则是由于思维检索到实例化的过程类似于人类思维,使模型能一致性地解决类似问题。

研究者还设计了一个问题蒸馏器来提取任务关键信息,并识别潜在约束,以减轻LLM在推理阶段的负担。通过元缓冲区,BoT方法能够为不同任务提供通用的推理方法,其中的思维模板分为六类:文本理解、创造性语言生成、常识推理、数学推理、代码编程和应用调度。

这种新颖的框架避开了传统单查询和多查询推理方法的局限性,通过思维模板的自适应实例化,为LLM的推理能力带来了显著的提升。这不仅优化了推理性能,还保持了较低的成本,平均只需增加提示方法成本的12%。

原文和模型

【原文链接】 阅读原文 [ 8311字 | 34分钟 ]

【原文作者】 新智元

【摘要模型】 glm-4

【摘要评分】 ★★★★★

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...