文章摘要

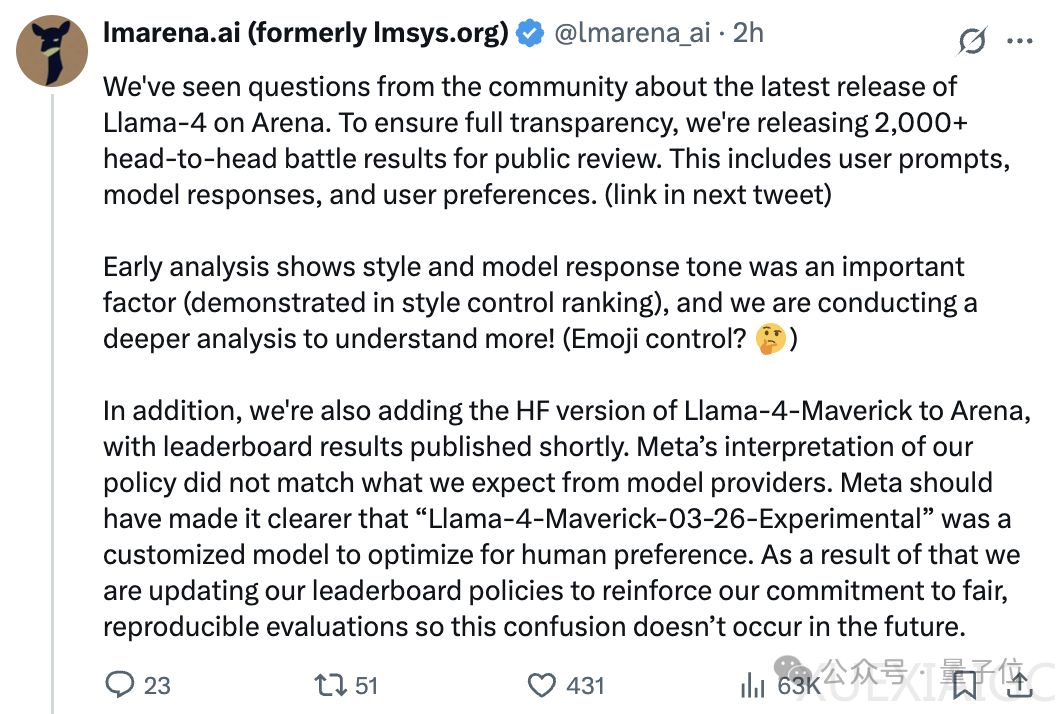

大模型竞技场(Chatbot Arena)官方团队lmarena.ai近日公开了对Llama-4-Maverick-03-26-Experimental版本的评测数据,并对其表现进行了详细分析。该模型在竞技场中的表现引发了广泛争议,尤其是其得分与实际表现之间的差异。lmarena.ai团队公开了2000余组模型对战数据,供公众审阅,并指出模型回复风格与语气是影响用户偏好的重要因素。团队还表示,Meta未明确标注Llama-4-Maverick-03-26-Experimental是经过人类偏好优化的定制模型,导致评测结果存在混淆。为此,竞技场正在更新排行榜政策,以强化对公平性和可复现性的评估。

在公开的对战数据中,Llama-4-Maverick-03-26-Experimental在代码生成任务中表现较为出色。例如,在生成网页游戏的测试中,该模型生成的代码能够正常运行,且计分准确,而对比模型command-a-03-2025生成的代码则存在明显bug。此外,在起标题任务中,Llama-4-Maverick-03-26-Experimental不仅提供了多个标题选项,还详细分析了选择标题时需要考虑的因素,展现出较强的细节处理能力。然而,尽管该模型在某些任务中表现优异,但其整体表现与竞技场中的高得分并不完全匹配,引发了对其评测结果的质疑。

Llama 4在大模型竞技场中的得分高达1417分,超越了此前Meta自家的Llama-3-405B,并成为榜单上排名第一的开源模型。然而,在实际应用中,该模型的表现却远未达到预期,甚至在某些基准测试中排名垫底。Meta GenAI负责人Ahmad Al-Dahle对此解释称,Llama 4并未使用测试集进行训练,表现差异是由于部署不稳定所致。然而,这一解释并未平息争议,部分用户认为这种现象在其他模型中从未出现,质疑Llama 4的评测结果存在人为操控。

此次事件不仅影响了Llama 4和Meta的声誉,也引发了对大模型竞技场评测方法的广泛讨论。部分用户指出,竞技场的评测结果存在偏差,不仅Llama 4被高估,Claude 3.7的表现也被低估。尽管lmarena.ai团队迅速回应并公开了评测细节,获得了部分用户的肯定,但仍有人认为,基于人类偏好的评测方法已不再适用于评价高级大模型的能力。有用户建议,应更新评测方法,例如更改ELO评分算法或启用强制风格转换,以更准确地反映模型的真实能力。

总体而言,Llama 4在竞技场中的高得分与实际表现之间的差异,暴露了当前大模型评测方法的局限性。无论是模型提供方还是评测平台,都需要在透明度和评测标准上做出改进,以确保评测结果的公正性和可靠性。

原文和模型

【原文链接】 阅读原文 [ 1851字 | 8分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆