模型信息

【模型公司】 OpenAI

【模型名称】 gpt-3.5-turbo-0125

【摘要评分】 ★★☆☆☆

文章摘要

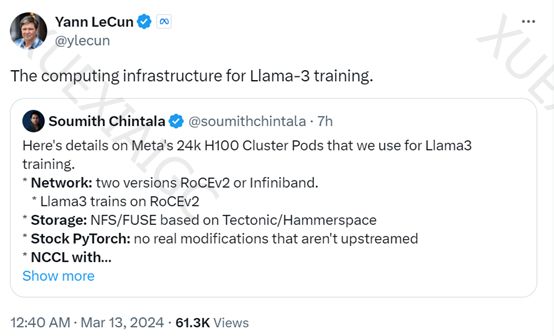

【关 键 词】 Meta、24K GPU、AGI、Grand Teton、存储方案

这篇文章介绍了Meta在AI领域的最新动态。Meta宣布推出两个全新的24K H100 GPU集群,用于训练大型模型Llama-3,预计将于4月末或5月中旬上线。Meta计划到2024年底拥有600,000个H100的算力,致力于构建通用人工智能(AGI)。这些GPU集群建立在之前16,000个英伟达A100 GPU的基础上,支持更复杂、参数更高的大模型训练。Meta的集群网络采用高效的网络结构,能够处理数百万亿次AI模型的请求。硬件平台使用了Meta内部设计的开放性GPU硬件平台Grand Teton,具有优化的设计和易于维护扩展的特点。数据存储方面,Meta采用了Tectonic分布式存储解决方案和Hammerspace合作开发的网络文件系统,以满足大规模AI集群的存储需求。这些技术的结合使Meta能够实现快速功能迭代,同时保持高效性和可扩展性。

原文信息

【原文链接】 阅读原文

【阅读预估】 1042 / 5分钟

【原文作者】 AIGC开放社区

【作者简介】 专注AIGC领域的专业社区,关注微软OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...