LeCun赞转!类Sora模型能否理解物理规律?字节豆包大模型团队系统性研究揭秘

文章摘要

【关 键 词】 视频生成、物理规律、模型泛化、记忆依赖、研究新方向

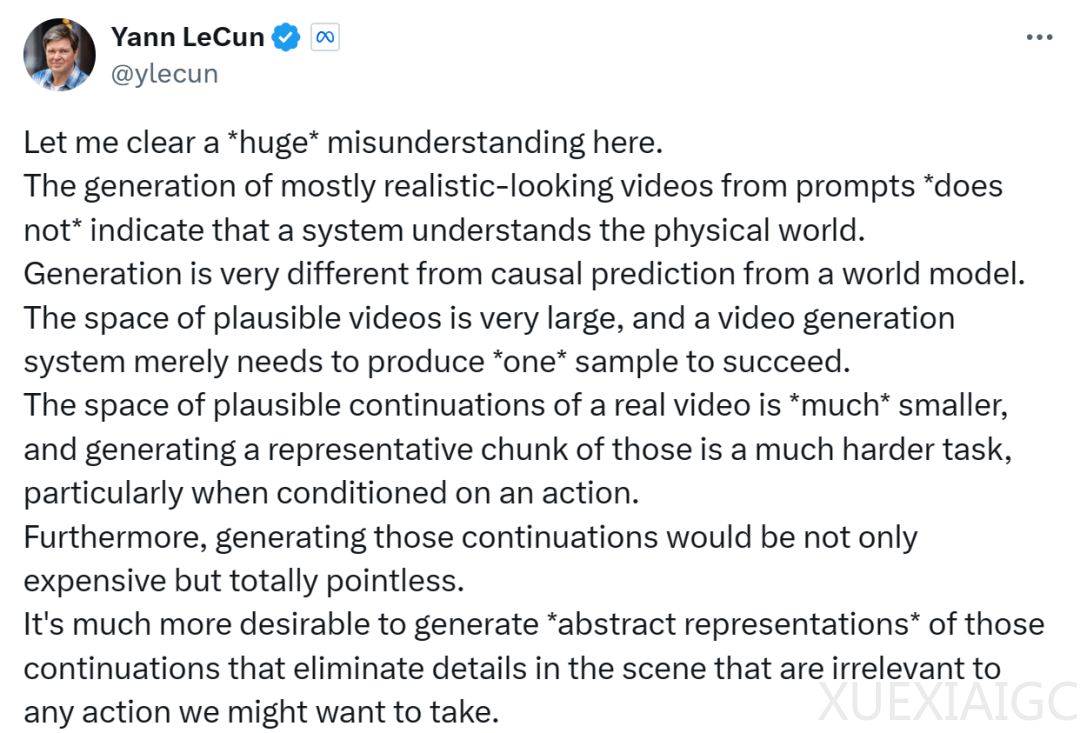

视频生成模型在生成看似符合常识的视频方面取得了进展,但业界对其是否真正理解物理规律存在争议。图灵奖得主Yann LeCun认为,基于文本提示生成的逼真视频并不代表模型真正理解物理世界,而Keras之父François Chollet则认为,视频生成模型嵌入了物理模型,但关键在于这个物理模型是否准确以及能否泛化到新情况。

字节跳动大模型团队的一项系统性研究为这一争论提供了新的视角。研究发现,即使扩大模型参数和训练数据量,视频生成模型依然无法抽象出一般物理规则,甚至连牛顿第一定律、抛物线运动都无法领会。研究者比喻称,视频生成模型目前就像一个只会“抄作业”的学生,可以记忆案例,但还无法真正理解物理规律,做到“举一反三”。

研究团队通过开发物理引擎合成经典物理场景的运动视频,用于训练基于主流DiT架构的视频生成模型,并检验模型生成的视频是否符合力学定律。实验设计包括分布内泛化(ID)、分布外泛化(OOD)和组合泛化三种场景。结果显示,模型在ID测试中随着规模和数据量的增加,速度误差降低,但在OOD测试中,扩展数据和模型规模对降低误差几乎没有影响。在组合泛化场景中,当训练集覆盖更多组合场景时,模型展现出更强的泛化能力。

研究还发现,视频生成模型更多依赖记忆和案例模仿,而非抽象出普遍的物理规则。模型通过颜色寻找相似参考生成物体运动状态,其次是大小,再次是速度,最后才是形状。此外,视频表征的局限性也导致在细粒度物理建模方面出现显著误差。

这项研究揭示了视频生成模型在理解物理规律方面的局限性,为未来研究提供了新的方向。研究者强调,视频生成的Scaling Law应侧重于增加组合多样性,而不仅仅是扩大数据量。

原文和模型

【原文链接】 阅读原文 [ 4228字 | 17分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★