LLM已能自我更新权重,自适应、知识整合能力大幅提升,AI醒了?

文章摘要

近期,关于AI自我演进的研究和讨论逐渐增多,多个机构提出了不同的自我改进框架。例如,Sakana AI与不列颠哥伦比亚大学合作的「达尔文-哥德尔机(DGM)」、CMU的「自我奖励训练(SRT)」、上海交通大学的多模态大模型持续自我改进框架「MM-UPT」以及香港中文大学与vivo合作的自改进框架「UI-Genie」。这些研究展示了AI自我改进的多样性和潜力。

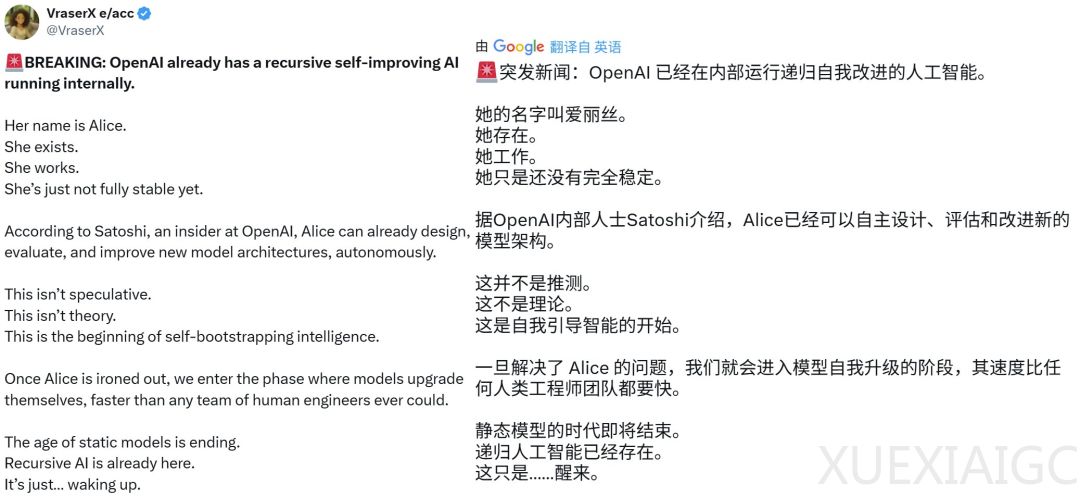

OpenAI CEO山姆・奥特曼在其博客《温和的奇点》中进一步探讨了AI自我改进的未来,设想了一个由AI驱动的供应链和制造设施的未来。尽管有用户爆料称OpenAI内部已运行能够递归式自我改进的AI,但这一消息的真实性仍存疑。然而,AI确实在向自我进化迈进,MIT最新发布的《Self-Adapting Language Models》便是例证之一。

MIT的研究提出了一种名为SEAL(Self-Adapting LLMs)的框架,该框架允许语言模型通过生成自己的训练数据(自编辑)并更新权重来实现自我提升。SEAL框架包含两个嵌套循环:一个外部强化学习循环用于优化自编辑生成,一个内部更新循环通过梯度下降更新模型。这种方法被视为元学习的一个实例,研究如何以元学习方式生成有效的自编辑。

SEAL框架在知识整合和少样本学习两个领域进行了实例化。在少样本学习实验中,使用Llama-3.2-1B-Instruct模型,SEAL显著提高了适应成功率,但仍低于Oracle TTT的表现。在知识整合实验中,使用Qwen2.5-7B模型,SEAL在单篇文章和持续预训练两种情况下均超越了基准表现。实验结果表明,SEAL方法能够快速收敛到一种将段落蒸馏为易于学习的原子事实的编辑形式,从而带来更佳的性能。

尽管SEAL框架在自我改进方面取得了显著进展,但仍存在一些局限,如灾难性遗忘、计算开销和上下文相关评估等问题。这些局限需要在未来的研究中进一步解决。总体而言,SEAL框架为AI自我改进提供了新的思路和方法,展示了AI在自我进化道路上的潜力。

最后,关于真正的自我进化式AI何时实现的问题,仍是一个开放性的讨论。随着研究的不断深入,AI自我进化的未来将逐渐明朗。

原文和模型

【原文链接】 阅读原文 [ 2717字 | 11分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★