Karpathy后悔了:2015年就看到了语言模型的潜力,却搞了多年强化学习

文章摘要

【关 键 词】 AI研究、大模型、强化学习、RNN潜力、自注意力

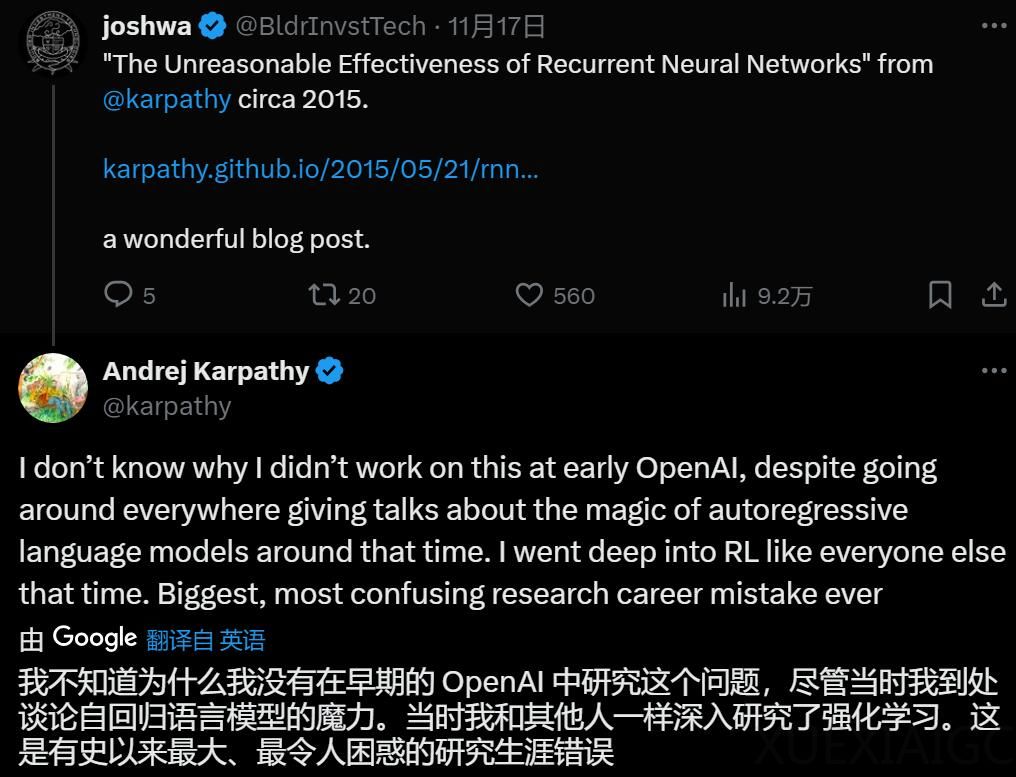

AI领域的重要人物Andrej Karpathy,曾是OpenAI的创始成员和特斯拉的AI高级总监,最近表达了对自己早期研究方向选择的遗憾。他认为自己没有及时引领OpenAI进入大模型时代,而是在强化学习领域“误入歧途”。Karpathy曾认为自回归语言模型具有巨大潜力,但当时却跟随主流研究强化学习。2013年的Atari RL论文标志着深度强化学习的开端,而OpenAI在2018年和2019年分别展示了强化学习在Dota 2游戏和解决实际问题如玩魔方的能力。然而,大语言模型(LLM)的兴起似乎取代了强化学习的繁荣。

Karpathy曾写过一篇名为《RNN的不合理有效性》的文章,探讨了循环神经网络(RNN)的潜力和应用。他通过实验示例,如生成类似莎士比亚作品的文本和模拟编程代码,展示了RNN的能力。Karpathy描述了RNN在图像描述任务中的初步尝试,并分享了其生成质量超出预期的神奇体验。他强调,尽管当时普遍认为RNN难以训练,但他的经验却显示RNN强大且稳健。

Karpathy还介绍了RNN的工作原理,并通过字符级语言模型的应用说明了其实际操作。他提供了一个简单的Python/numpy编写的字符级RNN语言模型,以及在Github上的其他示例。他特别提到了使用RNN生成莎士比亚风格文本的尝试,展示了RNN在字符级语言建模上的潜力。2017年,谷歌发布了Transformer论文,提出了自注意力机制,为大模型的发展奠定了基础。Karpathy的经历提醒我们,即使是AI领域的专家也可能在研究方向上“走过弯路”,这值得我们反思过去的研究选择。

原文和模型

【原文链接】 阅读原文 [ 2170字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★☆☆☆