文章摘要

【关 键 词】 AI发展、深度学习、预训练、超级智能、推理能力

在NeurIPS 2024会议上,Safe SuperIntelligence实验室创始人、原OpenAI联合创始人兼首席科学家Ilya Sutskever发表了题为《Sequence to sequence learning with neural networks: what a decade》的演讲,回顾了人工智能技术过去十年的进步,并对未来行业发展进行了展望。他提出预训练时代已经结束,并分享了对人工智能未来发展的重磅观点。

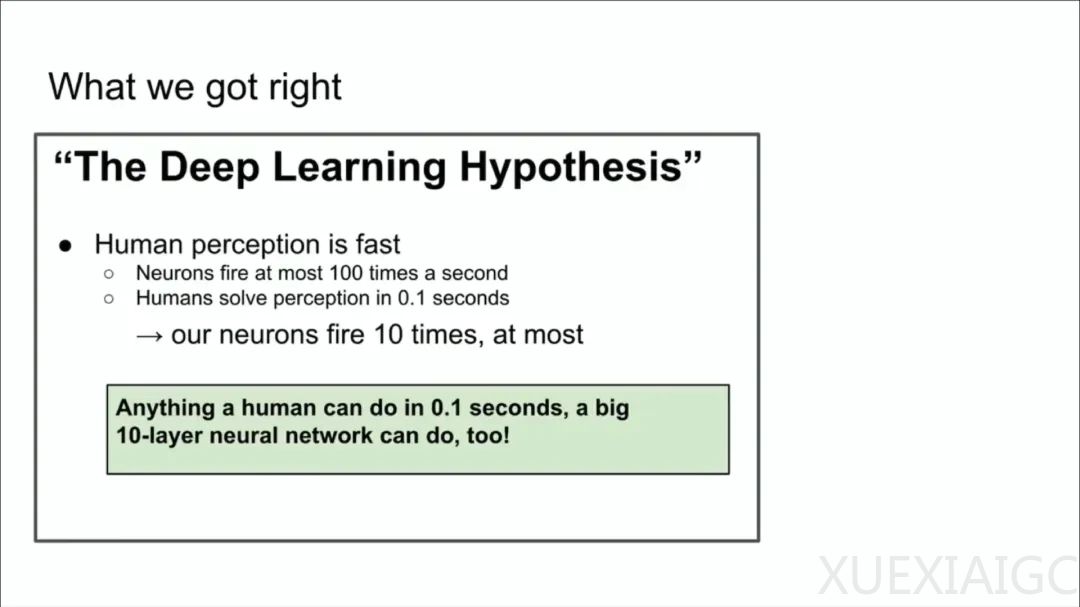

Sutskever在演讲中提到,十年前的论文《Sequence to sequence learning with neural networks》获得了NeurIPS时间检验奖。他回顾了当时工作的三个要点:文本上的自回归模型、大型神经网络和大型数据集训练。他强调了深度学习的假设,即十层大型神经网络能够做到人类在几分之一秒内能做的事情。他还提到了自回归模型的重要性,以及LSTM在Transformer之前的作用。

Sutskever讨论了并行化和流水线的概念,以及它们在当时的重要性。他指出,当时的结论是Scaling Law假设的起源,即拥有大量数据和大型神经网络就能成功。他认为这个想法引领了预训练时代的到来,推动了行业的进步。

然而,Sutskever认为预训练时代将终结,因为数据并没有增长,而计算能力在不断提升。他预测,未来行业将关注Agent、合成数据和推理时间计算等领域。他还提到了生物学的例子,展示了哺乳动物身体大小和大脑大小之间的关系,以及自然界探索不同比例的可能性。

Sutskever对超级智能的未来发展进行了推测,认为它将具有与现有智能不同的质量。他提到了代理化、推理能力和自我意识等概念,并认为这些将使人工智能系统具有不同的品质和属性。他还讨论了未来人工智能可能面临的问题,以及人类对这些挑战的预测能力。

在问答环节,Sutskever回答了关于人类认知生物结构、推理能力、人工智能权利和多跳推理等方面的问题。他认为,未来的模型将具备自我纠正和推理能力,而人工智能权利的问题需要更多的思考和探讨。他还强调了泛化能力的提升和模型在某种程度上的超越分布泛化能力。

总的来说,Sutskever的演讲提供了对过去十年人工智能发展的深刻反思,并对未来的发展方向提出了独到的见解。他的观点和预测为行业提供了宝贵的启示和思考。

原文和模型

【原文链接】 阅读原文 [ 4432字 | 18分钟 ]

【原文作者】 AI前线

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★