文章摘要

【关 键 词】 AI安全、深度学习、AGI、国际合作、风险控制

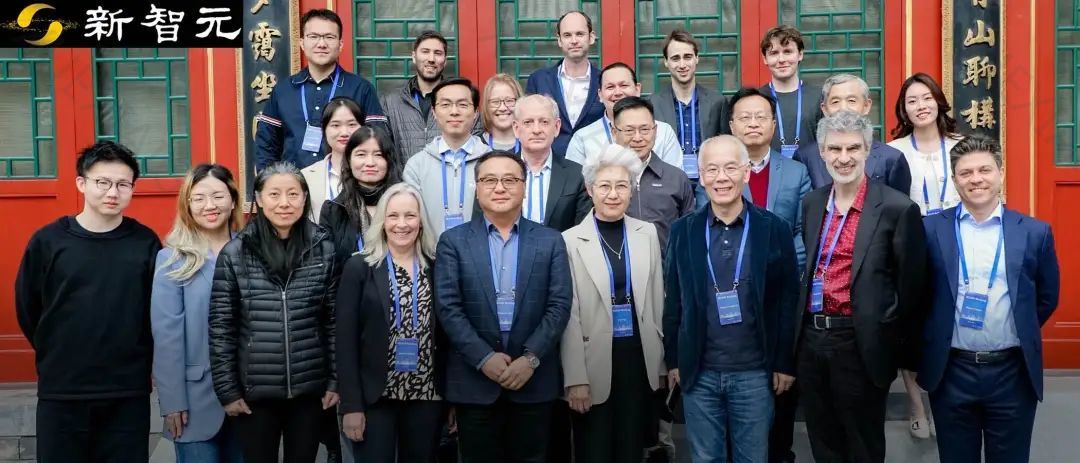

近日,深度学习之父Geoffrey Hinton等AI领域的重量级人物齐聚中国,参与了被誉为中国版“布莱切利”峰会的北京AI安全国际对话。在会议上,专家们签署了《北京AI安全国际共识》,共同探讨了AI的风险红线和安全治理路线。Hinton表示对生成式AI的恐惧,并对自已的工作表示后悔,他担忧数字智能终将取代生物智能。Yoshua Bengio也指出AI安全与核武器问题相似,应通过国际条约控制AGI项目的扩散。

在会议上,专家们普遍认为AGI的实现是一种必然,可能在10年或20年后降临。Bengio强调,AI的能力强于人类的同时,也越来越危险。一旦AI系统失控,落入恶意的人或组织手中,后果将不堪设想。Hinton则提出,人工智能的数字计算优于人类大脑的生物计算,随着能源成本降低,数字智能取代生物智能的可能性增大。他建议投入更多资源确保AI安全。

与会专家们认为,AGI项目的扩散问题与核武器问题相似,应通过国际合作与多边治理来控制。他们提出,所有国家应共同管理一个AGI项目,以构建稳定的世界秩序。最终目的是在分享AI红利的同时避免人类的终结。会议最后达成共识,落实AI风险红线和治理路线,呼吁国际学术界和政府在安全方面加强合作。

原文和模型

【原文链接】 阅读原文 [ 3419字 | 14分钟 ]

【原文作者】 新智元

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...