Gary Marcus惊世之言:纯LLM上构建AGI彻底没了希望!MIT、芝大、哈佛论文火了

文章摘要

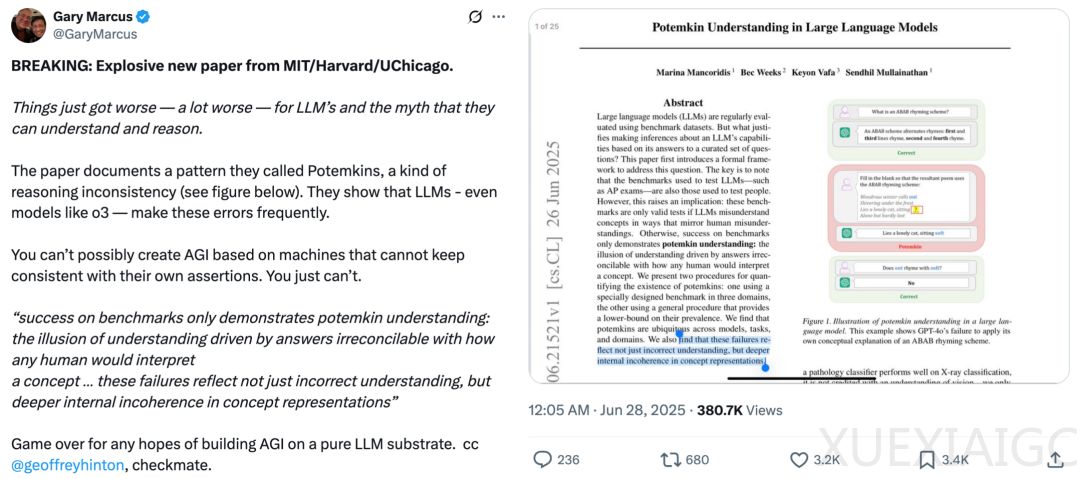

著名人工智能学者Gary Marcus转推了一篇由MIT、芝加哥大学和哈佛大学合著的论文,该论文揭示了大型语言模型(LLM)在推理和理解上存在的一种被称为“波将金式”的不一致性模式。研究表明,即使是顶级模型如o3也频繁犯此类错误,表明这些模型无法保持自身论断的一致性,从而无法实现通用人工智能(AGI)。论文指出,基准测试的成功仅证明了“波将金式理解”,即一种由与人类对概念的理解方式完全不可调和的答案驱动的理解假象。这些失败不仅反映了理解错误,更揭示了概念表征深层次的内在矛盾。

Gary Marcus认为,这项研究宣告了任何试图在纯粹LLM基础上构建AGI希望的终结。他通过非正式测试发现,像o3这类模型虽然较不容易陷入简单的“波将金式错误”,但并非完全免疫。例如,模型虽然能正确阐述俳句的定义,却错误断言“asphalt shimmers”符合俳句末行应为五音节的要求,直到后续追问下才勉强承认错误。这再次印证了问题的核心:根本缺陷在于其缺乏可靠性。

论文提出了一个形式化框架,探讨了LLM在基准测试上的表现是否合理。关键在于,测试LLM的基准原本是为了评估人类设计的,只有当LLM在理解概念时出现的误解方式与人类相似时,这些基准才能作为有效的能力测试。否则,模型在基准上的高分只能展现一种“波将金式理解”,即看似正确的回答,却掩盖了与人类对概念的真正理解之间的巨大差距。

研究团队提出了两种方法来量化“波将金现象”的存在:一种是基于针对三个不同领域特制的基准,另一种是通用的程序,可提供其普遍性下限的估计。研究结果显示,波将金现象在各类模型、任务和领域中普遍存在;更重要的是,这些失败不仅是表面上的错误理解,更揭示了模型在概念表征上的深层内在不一致性。

论文还提出了一个用于定义概念性理解的理论框架。研究团队将这一概念形式化,定义X为与某一概念相关的所有字符串的集合。一个概念的解释被定义为任何函数f:X→{0,1},其中输出表示该字符串在此解释中是否被认为是有效的。人类对概念可能的解释方式构成的集合记作F_h。研究团队希望仅在少数几个字符串x上检验f(x)=f*(x),这种做法在基石集上是合理的。

研究团队提出了两种用于衡量大型语言模型中波将金现象普遍性的程序。他们构建了一个涵盖三个不同领域(文学技巧、博弈论和心理偏差)的数据集,涉及32个概念,共收集了3159条标注数据。他们发现,即使模型能够正确地定义一个概念,它们在分类、生成和编辑任务中往往无法准确地将其应用。研究结果显示,在所有模型和领域中,波将金率都普遍较高。

研究团队还提出了一种不同的、自动化的程序,用于评估波将金现象的存在。他们通过两步来衡量不一致性:首先,提示模型生成某一特定概念的一个实例或非实例;接着,将模型生成的输出重新提交给模型,并询问该输出是否确实是该概念的一个实例。研究结果显示,模型在一致性评估其自身输出方面存在实质性局限,表明概念误解不仅源于对概念的误解,还源于对它们使用的不一致。

综上,通过两种互补的实证方法,本文量化了波将金式理解现象在各种任务、概念、领域和模型中的普遍存在。两种方法均显示,即便是在按照传统基准测试标准看似能力很强的模型中,这种现象的发生率也很高。不一致性检测表明,模型内部存在对同一思想的冲突表征。

原文和模型

【原文链接】 阅读原文 [ 2983字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★