文章摘要

【关 键 词】 AIGC发展、算力需求、CXL技术、内存池化、异构计算

生成式人工智能(AIGC)的快速发展对算力芯片提出了更高的要求,同时也暴露了传统系统设计在计算需求方面的不足。在2024开放计算中国峰会上,专家指出,内存和I/O的扩展能力已远落后于计算密度的增长,导致平均到每个核心的内存和I/O带宽持续下降。随着AIGC时代的到来,内存需求大幅增加,同时也产生了梯度数据聚合与分发等海量I/O通信需求。为了缓解系统内存和I/O瓶颈,实现数据处理规模、并行处理能力和系统算力的提升,需要采用新的架构。

CXL(Compute Express Link)作为一种开放标准的高速互联协议,旨在解决计算器件和内存之间的互联问题,改善处理器与加速器、内存扩展设备等之间的通信。CXL通过现有的PCIe物理层传输信号,但在协议层面上引入了新的特性和改进,显著提升了系统中处理器、加速器和内存设备之间的数据交换效率和一致性,降低了延迟,减少了软件堆栈的复杂性,并降低了整体系统成本。

CXL具有以下三个关键特征:

1. 统一的内存模型:CXL支持CXL.io、CXL.cache和CXL.memory三种协议,其中CXL.cache和CXL.memory提供了缓存一致性和内存访问能力,使得CPU与加速器或内存扩展设备之间能够共享和一致性地访问内存。

2. 缓存一致性:CXL允许处理器和外部设备(如加速器)共享相同的内存空间,并保持缓存的一致性,减少了数据在不同设备之间传输时的复制或同步,提高了性能。

3. 高带宽低延迟:CXL通过优化的协议栈,在维持高带宽的同时提供低延迟的通信,适合AI加速、数据分析等需要快速数据交换的应用。

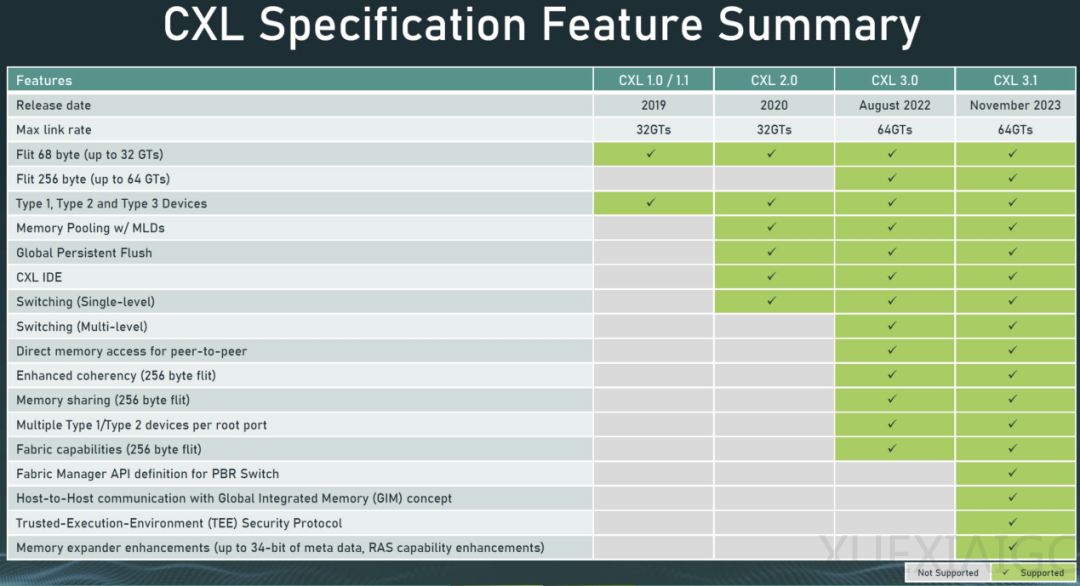

CXL自2019年首次发布以来,已演进至CXL 3.1标准,适用范围也从最初的有限功能增加到对横向扩展CXL进行了额外的结构改进、新的可信执行环境增强以及内存扩展器的改进。CXL联盟预计,到2028年,CXL市场总收入将增长至150亿美元以上,其中DRAM将占市场收入的大部分。

产业链玩家纷纷加入CXL联盟,抓住这一新机遇。英特尔作为CPU产业龙头和CXL的主要推动者之一,持续推进CXL技术的发展和普及。浪潮信息从2022年开始推出CXL产品,如CXL1.1时代的内存远端扩展和CXL 2.0时代的内存池化硬件解决方案。内存池化技术可以构建全局内存资源池,优化内存的总体利用率,实现内存资源的动态分配与回收。

阿里云作为CXL联盟董事会成员和创始成员之一,全程参与了CXL协议的制定和迭代演进。阿里云超高速互联负责人孔阳表示,CXL能有效地扩展内存带宽和容量,并实现内存池化共享。阿里云在CXL方向上的研发一直走在业界前列,推出了一系列产品和技术,并联合多个业务方和合作伙伴进行了解决方案的探索。阿里云形成了支持CXL的通用计算服务器、CXL Switch软硬件系统、Alimemory(CXL Memory)、AliSCM(CXL Pmem)、Memory Box等较为完整的产品布局。

随着越来越多的生态合作伙伴加入,CXL技术将迎来蓬勃发展。CXL提供的内存语义和缓存一致性协议对于AI等应用具有天然优势,尤其是内存扩展、池化、共享等技术。CXL也将推动CPU与加速器(如GPU、FPGA、AI专用芯片)之间的高速、低延迟通信的异构计算普及。在CXL的推动下,高效率的数据中心成为可能,这项技术将成为云计算、大规模AI模型训练、实时数据分析和边缘计算等应用的重要支柱。

原文和模型

【原文链接】 阅读原文 [ 3287字 | 14分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★