文章摘要

在计算机图形和视觉领域,渲染与逆渲染是两个核心任务,分别涉及从3D模型生成2D图像和从2D图像解析3D属性。传统方法通常需要独立建模渲染器和逆渲染器,导致计算成本高、效率低且泛化能力差。然而,港科大广州与趣丸科技的研究团队提出了一种首创的双流扩散框架Uni-Renderer,将渲染与逆渲染统一到一个单一框架中,实现了“生成即分解”的闭环能力。这一成果已被CVPR 2025接收,并全面开源代码与数据。

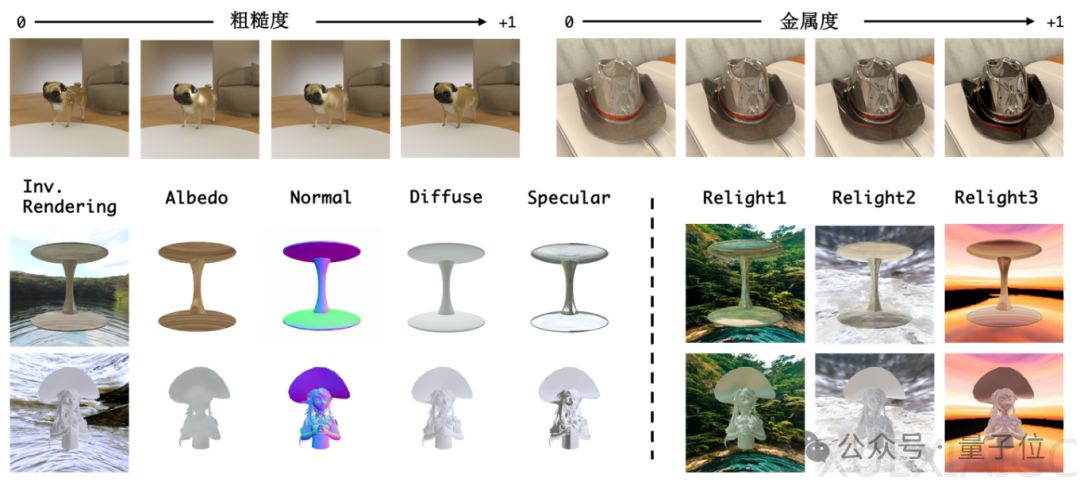

Uni-Renderer的核心创新在于其双流扩散架构,将渲染和逆渲染建模为双条件生成任务。在渲染流中,模型以材质、光照等为条件生成RGB图像,支持动态调整粗糙度和金属值,例如将“光滑棒球”瞬间变为“金属质感”。在逆渲染流中,模型以图像为输入,通过噪声预测网络分解材质、光照和几何属性,并在网络内部进行跨流交互,实现信息传递与优化协同。此外,团队采用了差异化的timestep调度策略,使模型能够更好地区分渲染和逆渲染的映射关系,进一步提升协同效果。

为了解决传统逆渲染中“材质-光照-几何”耦合性导致的分解模糊问题,Uni-Renderer引入了一种循环约束机制。具体而言,逆渲染分解得到的属性会再次输入到渲染模块进行再渲染,并通过循环约束确保分解结果能够重新生成一致的图像,从而彻底告别“分解即失真”的难题。这一机制显著提升了分解的精度和一致性。

在性能方面,Uni-Renderer在多个任务中表现优异。在材质编辑任务中,模型能够精准控制高光与漫反射,生成逼真的细节,例如“金属橙子”表面反射环境光照的效果。在重光照任务中,模型能够根据单张图像直接替换环境光,如“夕阳/霓虹”,并自动调整漫反射与镜面反射,光影过渡自然,超越现有方法。在真实场景测试中,模型成功解析了高频环境光,金属质感与粗糙度误差仅为3%。总体而言,Uni-Renderer在生成阶段的效率提升了200%,在公开测试集上材质估计误差降低了40%,光照分解的PSNR提升了30%。

此外,研究团队基于Objaverse构建了业界最大规模的多材质合成数据集,涵盖20万3D对象和121种材质/光照组合,支持高分辨率(1024×1024)训练。这使得模型在未见过的真实场景中仍能精准分解高光、粗糙度与复杂光照。在渲染任务中,模型的PSNR达到30.72,逆渲染任务中材质估计的MSE仅为0.118,重光照效果超越现有方案,真实感显著提升。

目前,团队已对Uni-Renderer进行了全面开源,包括代码库、合成数据集和预训练模型,支持一键训练与推理,兼容PyTorch生态。这一框架可广泛应用于游戏资产生成、影视后期、工业设计等场景。未来,团队计划进一步融合真实数据,攻克复杂动态场景,推动人工智能成为“全能视觉工程师”。Uni-Renderer的提出标志着视觉生成与解析从“分而治之”迈入“统一智能”时代,其双流架构与循环约束机制为跨任务联合优化提供了全新范式。

原文和模型

【原文链接】 阅读原文 [ 1287字 | 6分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-v3

【摘要评分】 ★★★☆☆