CVPR 2024 | 面部+肢体动画,一个框架搞定从音频生成数字人表情与动作

文章摘要

【关 键 词】 AI数字人、驱动算法、全身动作、EMAGE框架、BEAT2数据集

近年来,随着虚拟现实、虚拟直播和游戏NPC等领域的发展,AI数字人的面部与肢体驱动算法成为了研究的热点。这些算法能够根据语音生成相应的面部表情和肢体动作,从而降低相关领域的驱动成本。然而,目前市场上的独立基线模型虽然在各自的领域内逐渐成熟,但将不同模型的动画结果混合使用时,往往会出现全身动画不协调的问题。为了解决这一问题,研究者开始考虑使用统一框架来同时生成面部表情和肢体动作。

尽管面部表情和肢体动作各自有统一的数据标准,如FLAME和AMASS,但现有的基线模型通常只在独立的数据格式上进行训练和评估,导致缺乏面向全身的、格式统一的训练数据和基线模型。为了填补这一空白,东京大学、清华大学和德国马普所的研究者们联合提出了EMAGE框架,这是一个能够从音频和动作掩码中生成人体全身动作的框架,包括面部、局部肢体、手部和全局运动。

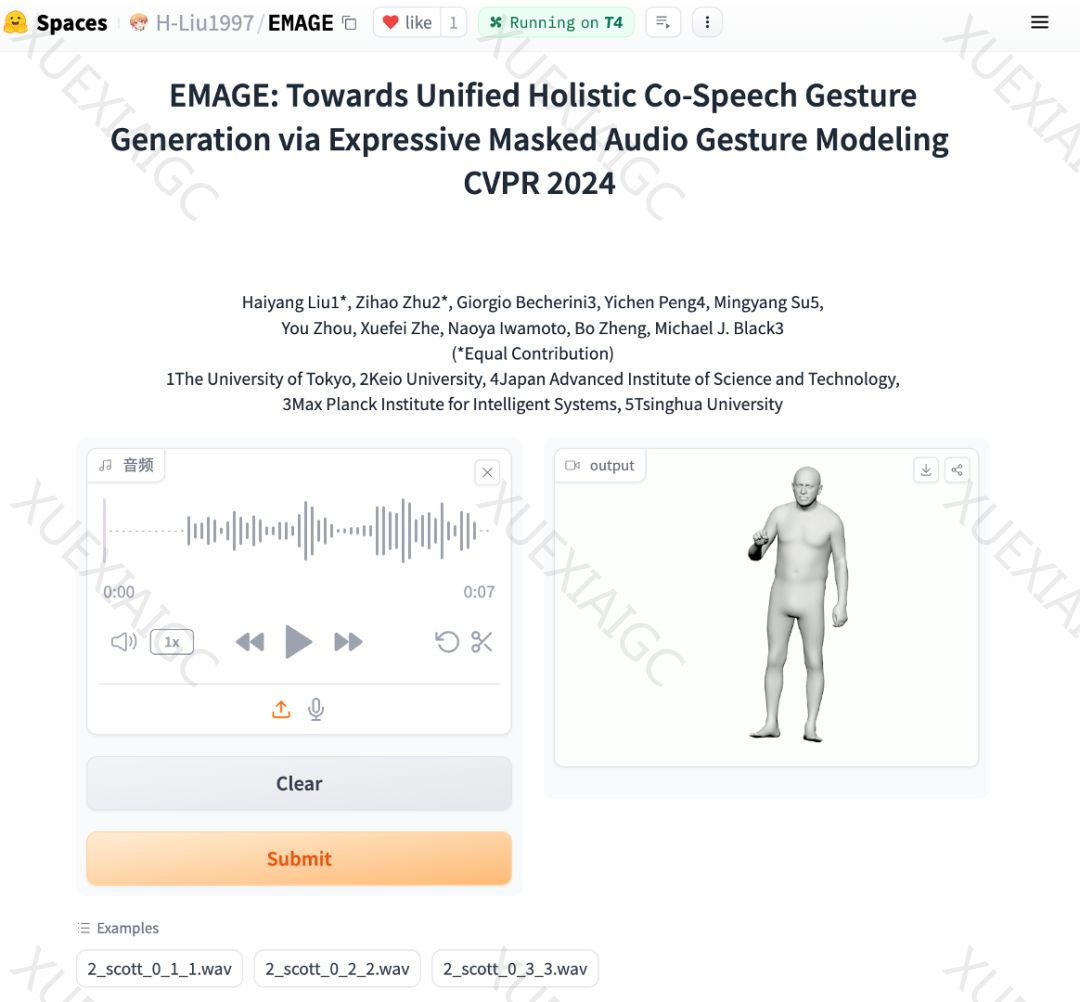

EMAGE研究论文介绍了BEAT2和EMAGE两部分。BEAT2是一个全身数据集,包含60小时的数据,结合了SMPLX的肢体参数和FLAME的面部参数,并解决了头部、颈部和手指等运动的模型问题。EMAGE框架在训练过程中利用了肢体动作掩码的先验知识,通过音频与动作掩码的转换器提高了训练效率,并结合了音频的节奏和内容特征,使用组合式VQ-VAEs增强了结果的真实性和多样性。

EMAGE能够生成与音频同步的多样化肢体动作,并能灵活接受非音频同步的肢体提示帧,以此明确引导生成的动作。在面部动画生成方面,EMAGE利用离散的面部先验知识和动作掩码的肢体提示帧,实现了更精准的唇动性能。

EMAGE框架支持用户自定义输入,带有动作掩码与音频输入的全身动作建模。算法细节方面,EMAGE采取了动作掩码重建(MG2G)和使用音频的动作生成(A2G)两种训练路线。MG2G通过基于Transformer的动作时空编码器和基于交叉注意力的动作解码器来编码肢体提示帧。A2G则利用输入的肢体提示与独立的音频编码器对面部和肢体潜征进行解码。此外,EMAGE还使用了内容节奏注意力模块(CRA)和组合式VQ-VAEs模型来提高生成动作的语义性和解耦与音频无关的动作。

总体来说,EMAGE框架的提出为AI数字人的全身动作生成提供了一个统一的解决方案,有望在虚拟现实、虚拟直播和游戏NPC等领域发挥重要作用。

原文和模型

【原文链接】 阅读原文 [ 1874字 | 8分钟 ]

【原文作者】 机器之心

【摘要模型】 gpt-4

【摘要评分】 ★★★★☆