文章摘要

【关 键 词】 3D人体运动预测、SIF3D技术、注意力机制、机器智能、自动驾驶

< strong >SIF3D(Sense-Informed Forecasting of 3D human motion)是一种由小红书创作发布团队提出的先进场景感知运动预测技术,已被计算机视觉顶会CVPR2024收录。< / strong>该技术通过结合人过去的动作序列、真实3D场景信息以及人的视线,预测未来的人体运动,特别擅长理解和预测复杂环境中的动作,如避开障碍物。这对于自动驾驶、机器人导航、游戏开发和虚拟现实等领域至关重要。

< strong >SIF3D的工作原理包括两种创新的注意力机制:三元意图感知注意力(TIA)和场景语义一致性感知注意力(SCA)。< / strong>TIA专注于预测人的意图和全局动作轨迹,而SCA则专注于局部场景细节,确保每一帧的姿态预测都与环境保持连贯性。实验结果表明,SIF3D在多个大规模场景感知运动预测的数据集上表现出色,预测时长可达5秒。

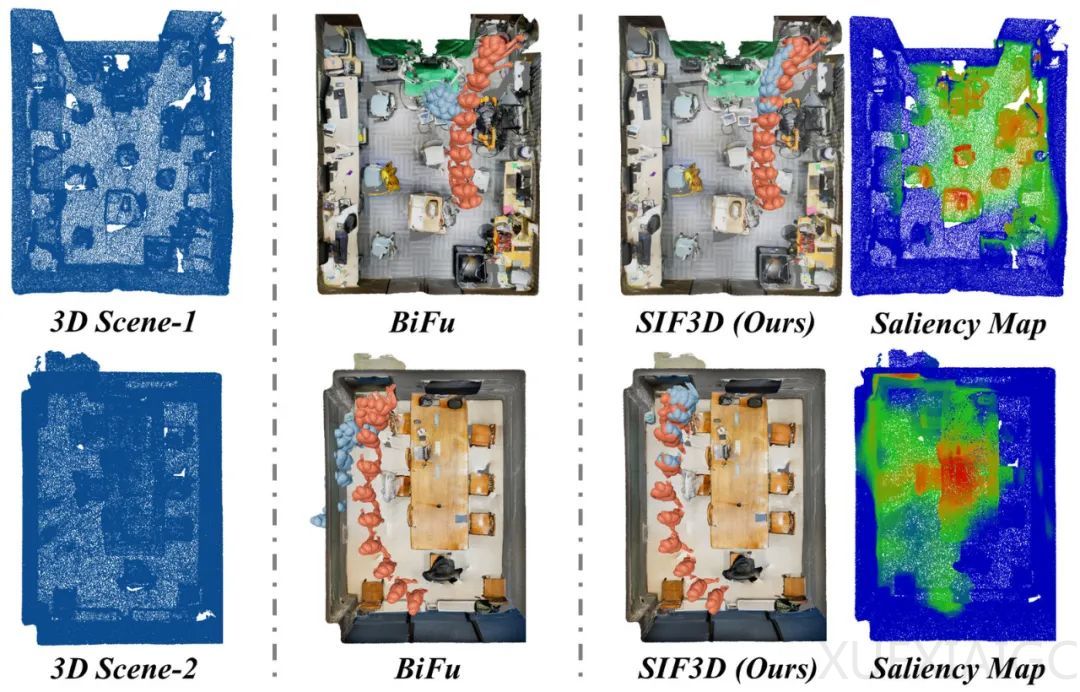

< strong >人体动作预测是机器智能、自动驾驶汽车和人机协作等领域的关键技术。< / strong>SIF3D通过联合分析3D场景和人眼凝视点,捕捉人类向特定位置的运动行为,从而更准确地预测其运动序列。该技术包含两个核心组件:三元意图感知注意力机制(TIA)和场景语义一致性感知注意力机制(SCA)。TIA通过观测序列、场景点云、人眼凝视的三元多模态联合分析,预测人的意图并区分全局显著点云,用于辅助人体运动轨迹预测。SCA则逐帧分析运动序列与场景语义的连贯性与一致性,区别得到逐帧的局部显著点云,用于辅助人体姿态预测。

< strong >SIF3D算法流程包括三个核心步骤:编码、跨模态注意力和解码。< / strong>编码阶段,通过点云网络和Transformer提取3D场景的空间信息与运动序列的时间、空间信息,并将其编码为高维隐藏特征。跨模态注意力阶段,通过TIA和SCA提取3D场景中的全局与局部显著点云,并通过跨模态注意力机制分别辅助运动轨迹与姿态的预测。解码阶段,融合TIA与SCA预测的轨迹与姿态,并使用真伪判别器进一步监督预测序列的保真度。

< strong >SIF3D在真实场景下的3D人体运动预测方面取得了优越的性能,< / strong>证明了其捕获显著点云的准确性,以及通过显著点云辅助运动预测的有效性。这些发现为基于真实场景的高保真运动预测、人机交互等领域的应用提供了新的视角和可能性。

原文和模型

【原文链接】 阅读原文 [ 6063字 | 25分钟 ]

【原文作者】 小红书技术REDtech

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★