文章摘要

【关 键 词】 AI芯片、能效优化、NPU、AI算法、可编程性

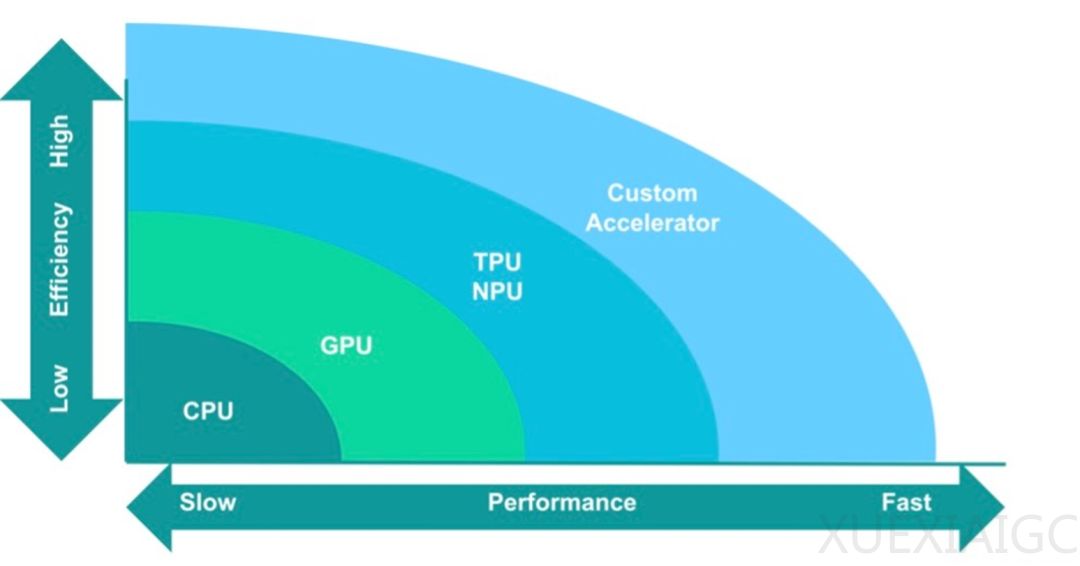

随着人工智能模型的复杂性不断增加,芯片制造商面临着在固定功能加速和可编程加速器之间做出选择的挑战。通用处理器由于不是为特定工作负载设计的,因此在AI处理方面表现不佳。AI模型的功耗占据了系统功耗的很大一部分,因此针对特定用例进行优化可以在更小的占用空间内实现更大的功耗节省和更好的性能。Rambus的研究员Steven Woo指出,人工智能对计算和半导体行业产生了深远的影响,已经采用了专门的处理器架构,并开发了仅服务于人工智能市场的专用组件。

然而,这种专业化是以牺牲灵活性为代价的。Arm的研究员Ian Bratt提到,对于ML和AI来说,计算需求是无止境的,这推动了针对该工作负载的优化。不同类型的NPU可以在特定类别的神经网络模型上实现非常好的能源效率,但这种专业化牺牲了面向未来的灵活性。因此,一些工程团队正在研究不同的优化方法,如在通用计算平台上增加更多内部加速,同时不牺牲通用可编程性。

提高效率至关重要,它影响着从超大规模数据中心训练人工智能模型所需的能量到进行推理的边缘设备的电池寿命。Ansys的产品营销总监Marc Swinnen解释了训练和推理的本质区别,指出反向传播需要大量能量来完成所有计算。随着人工智能算法变得越来越复杂,浮点运算的数量增加,对更多处理能力的需求也在不断增长。

西门子数字工业软件的高级综合部门项目总监Russ Klein指出,过去五年来,获胜的ImageNet‘Top1’算法执行的浮点运算数量增加了100倍。AI算法通常具有高度数据并行性,这意味着操作可以分布在多个CPU上,但这样做所需的能量可能非常高。GPU和TPU通常具有更高的功耗,但计算速度更快,从而降低了相同操作的能耗。

AI的快速发展得益于计算性能和容量的巨大进步,我们正处于AI 2.0时代,其特点是系统现在可以从它们学习到的数据和它们获得的输入中创造出新的东西。这些技术中最重要的是大型语言模型和生成式人工智能,以及帮助人类提高生产力的副驾驶和数字助理。人工智能模型的规模一直在急剧增长,每年增长约10倍或更多,因为更大的模型提供了更高的准确性。

随着算法的复杂性不断增加,设计人员被迫追求更高水平的加速。加速器越是针对特定模型进行量身定制,它的速度就越快、效率就越高,但通用性就越差。而且它对应用和需求变化的适应性也会降低。芯片设计师需要了解许多有关定制AI引擎的注意事项,因为当你获得高度定制或定制程度不一的产品的授权时,你得到的东西就会有所不同。

结论是,AI/ML已经足够成熟,我们将看到在人们真正关心能源效率且工作负载较慢的情况下,例如深度嵌入式环境,你会看到这些专用的NPU具有针对这些NPU的高度优化模型,你将获得出色的性能。但总的来说,像CPU这样的可编程平台将继续向前发展。它们将在ML方面不断进步,并且它们将运行那些全新的工作负载。随着情况稳定下来,对于某些垂直行业,你将采用在可编程平台上运行的那些模型,并针对NPU对其进行优化,你将在嵌入式垂直领域(如监控摄像头或其他应用程序)中获得最佳性能。这两种模式将在未来相当长的一段时间内共存。

原文和模型

【原文链接】 阅读原文 [ 5934字 | 24分钟 ]

【原文作者】 半导体行业观察

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★