AI编程「反直觉」调研引300万围观!开发者坚信提速20%,实测反慢19%

文章摘要

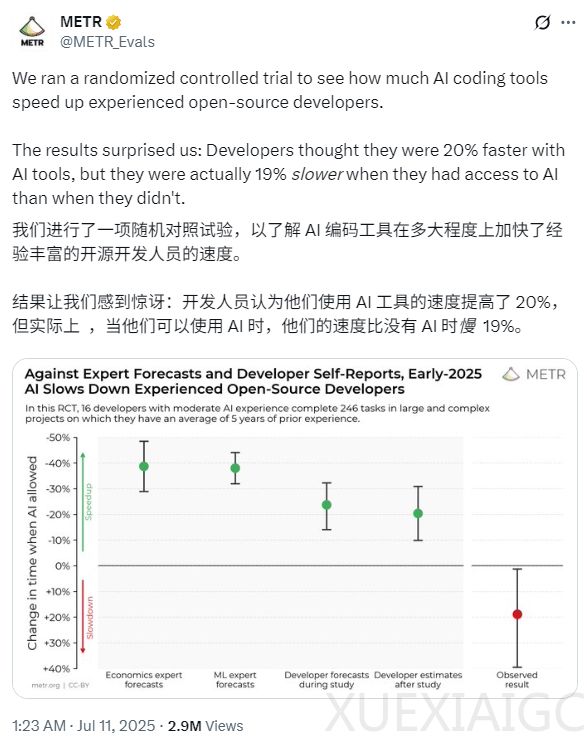

随着大模型的崛起,AI编程工具在开发者社区中引发了广泛关注。这些工具通过自动补全代码、自动调试等功能,被认为能够显著提升开发效率。然而,一项由非营利性AI调研机构METR进行的随机对照实验却得出了令人意外的结论:经验丰富的开发者在使用AI编程工具后,完成任务的速度反而比未使用时慢了19%。这一发现与开发者的预期形成了鲜明对比,他们原本认为AI工具能够将速度提升20%。

实验招募了16位拥有中等AI编程经验的开发者,他们平均拥有5年开发经验,并参与了246项大型复杂项目的任务。这些任务包括bug修复、功能开发和重构,属于他们日常工作的范畴。METR随机分配任务,允许或禁止开发者使用AI工具,并记录他们的完成时间。结果显示,使用AI工具的开发者花费的时间明显更长,尽管他们在主动编码和查找信息上的时间减少了,但他们更多地将时间花在了撰写提示词、等待或审查AI输出以及处于空闲状态上。

METR进一步分析了实验环境中的20项属性,发现其中5项可能是导致开发速度放缓的主要原因,另有8项表现出混合或不明确的影响。实验排除了许多干扰因素,如开发者使用了前沿模型、遵守了处理分配规则,并且在使用和不使用AI的情况下提交了质量相近的PR。无论采用何种结果指标或估计方法,开发速度的放缓现象依然存在。

此次调研得出了两个重要结论:在某些重要场景下,近期的AI工具可能并未提升生产力,甚至可能导致效率下降;关于效率提升的自我报告并不可靠,真实环境中的实验数据才是理解AI对生产力影响的关键。METR也指出,他们的实验设置并未涵盖所有软件工程场景,未来的模型可能会更有效地利用起来。

这项研究为AI编程工具的实际效果提供了新的视角,强调了在评估AI工具时需要考虑真实环境中的复杂性和多样性。未来的研究需要继续开发和使用多样化的评估方法,以更全面地描绘AI的现状和未来发展方向。METR计划运行类似的调研,以追踪AI带来的加速或减速趋势,这类评估方法可能比基准测试更难被“玩弄”。

原文和模型

【原文链接】 阅读原文 [ 1791字 | 8分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★☆