文章摘要

【关 键 词】 AI电源芯片、能耗问题、散热挑战、功率密度、技术突破

随着人工智能技术的飞速发展,AI电源芯片的需求量急剧增加。这些芯片不仅需要为AI系统提供稳定的电力供应,还要在节能减排和降低能耗方面发挥作用。但是,AI设备的能耗和散热问题随着算力需求的提升而日益突出,这对AI供电芯片提出了新的挑战。

能耗问题是AI发展的一个重要障碍。随着从CPU到GPU的转移,虽然计算效率得到了提升,但高性能也意味着高能耗。数据中心和服务器因此面临巨大的能源压力。研究表明,如果按照当前趋势发展,到2027年,人工智能行业每年的电力消耗量将达到惊人的85至134太瓦时。

散热问题也是AI芯片发展的一个瓶颈。高性能AI芯片在运行时产生的大量热量若不能及时有效散热,将影响设备的稳定运行并可能缩短使用寿命。目前,单颗高性能AI芯片的热设计功耗已经接近传统风冷散热的极限,迫使企业寻求更有效的散热解决方案,如液冷技术。

可靠性问题同样不容忽视。AI应用对芯片的性能和可靠性要求极高,一旦在大模型训练中有一张计算卡出现问题,整个训练过程都会受到影响,严重影响训练效率。

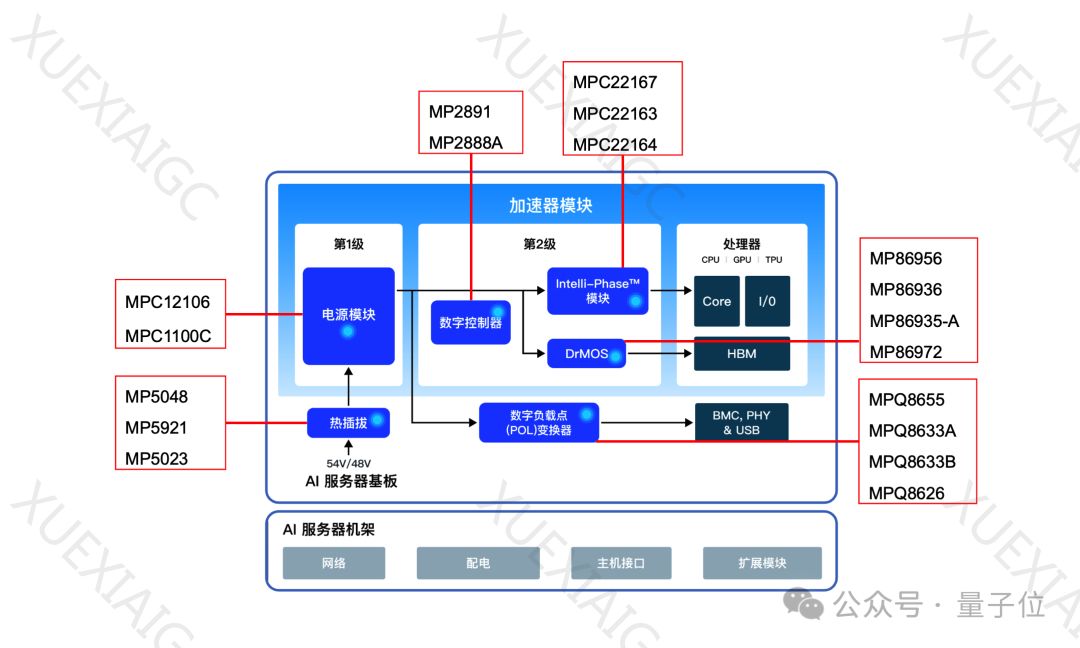

MPS公司在AI电源解决方案方面取得了四大突破,以应对上述挑战。首先,MPS的AI电源方案采用创新设计,实现了体量更紧凑、功率密度更高、配电损耗更低的产品,提升了数据中心的计算能力。其次,MPS优化了电源转换效率,降低了功耗,并采用了顶部散热设计,兼容液冷应用,以增强服务器散热效果。第三,MPS通过严密的仿真计算和严格的出厂测试,确保了产品的一致性和可靠性。最后,MPS提供了实用的仿真工具、专业的技术支持和灵活的供应链管理,以支持AI对芯片的大规模需求。

总结来说,MPS的AI电源解决方案通过提高数据中心的计算能力、创新电源架构、减少服务器配电损耗、提升AI算力的同时有效降低能耗,助力节省能源和降低运行成本。同时,MPS的多项优势也为客户在设计方案时提供了便利和保障。

原文和模型

【原文链接】 阅读原文 [ 2126字 | 9分钟 ]

【原文作者】 量子位

【摘要模型】 gpt-4

【摘要评分】 ★★★★★