模型信息

【模型公司】 OpenAI

【模型名称】 gpt-3.5-turbo-0125

【摘要评分】 ★★★★☆

文章摘要

【关 键 词】 社区、AIGC、LLM、市场研究、开发者生态

摘要:

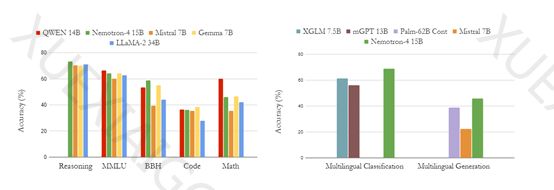

在AIGC领域的专业社区中,关注着微软 & OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地。英伟达最新推出的Nemotron-4 15B拥有150亿参数,基于8万亿文本标注数据进行了预训练。该模型在数学、多语言分类、代码等领域的测试评估中表现优异,超过了同类大小的开源模型。Nemotron-4 15B采用了标准的Transformer架构,包括多头自注意力机制和前馈神经网络。通过注意力机制,模型能够更好地理解输入序列中的依赖关系和上下文信息。在训练过程中,研究人员利用了大量的GPU节点和分布式优化器,取得了令人瞩目的成果。Nemotron-4 15B在英语评估领域和广泛的代码语言中展现出了优越性能,显示出其在AIGC领域的潜力和价值。

关键词:

– Nemotron-4 15B: 英伟达推出的拥有150亿参数的大语言模型。

– Transformer架构: 包括多头自注意力机制和前馈神经网络。

– 注意力机制: 用于理解输入序列中的依赖关系和上下文信息。

– 训练过程: 利用大量GPU节点和分布式优化器取得优异成果。

– 性能优势: 在英语评估领域和广泛的代码语言中展现出优越性能。

原文信息

【原文链接】 阅读原文

【阅读预估】 913 / 4分钟

【原文作者】 AIGC开放社区

【作者简介】 专注AIGC领域的专业社区,关注微软OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...