500万TPM+20msTPOT,火山引擎用「AI云原生」重构大模型部署范式

文章摘要

【关 键 词】 AI服务、云部署、火山引擎、AI云原生、技术优势

部署DeepSeek系列模型,尤其是推理模型DeepSeek-R1,已成为AI和云服务商以及企业和组织提供AI服务的重要手段。学校也在部署DeepSeek-R1辅助教育,培养学生正确使用AI的价值观。然而,本地部署DeepSeek-R1对大多数企业和组织而言并非最优选择,因为它需要在技术、安全和运维等方面投入大量资金和人力资源。因此,基于云的部署成为更合理的选择,国内主要云服务商如腾讯云、阿里云和火山引擎等都在争夺这一市场份额。

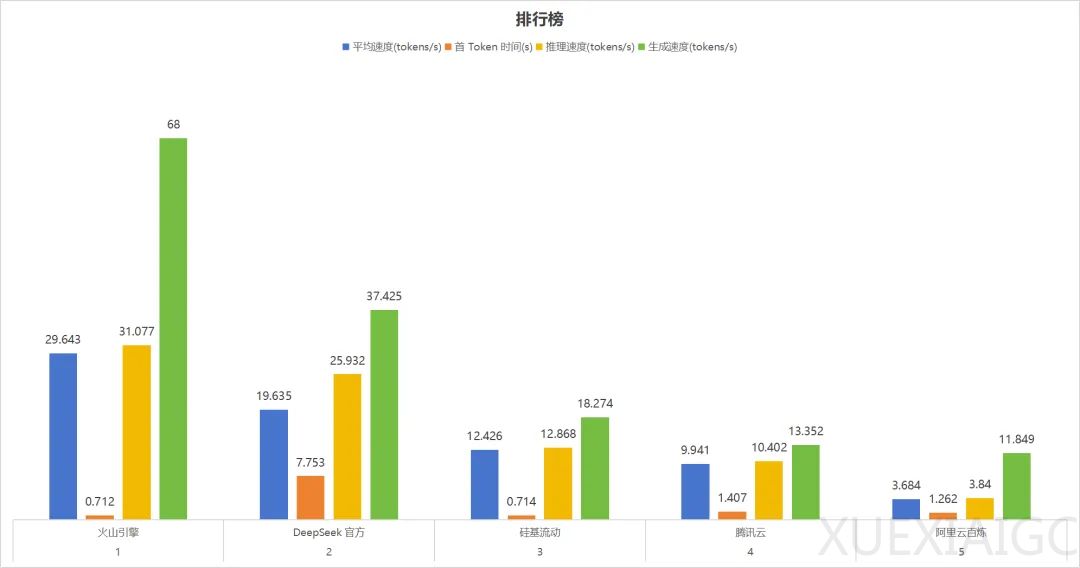

火山引擎因其高速、可靠和安全的服务,在AI模型部署上具有优势,被认为是最有可能夺得这场竞赛头筹的云服务商。火山引擎在速度和性能上得到了第三方评测平台的认可,其平均速度、推理速度、生成速度表现最优,可用性高达99.83%,在API接入上首选推荐。火山引擎领先全网将每位用户的初始TPM(每分钟token数)上调到了500万,成功将TPOT(输出每个Token的时间)稳定地降低到了约20ms,成为国内延迟最低的大规模AI模型推理服务。

火山引擎之所以能成为后发先至的云服务商,主要得益于其为AI时代的云服务总结出了自己的方法论:AI云原生。AI云原生是将云原生理念应用到AI领域,专注于AI工作负载的云端构建和部署。火山引擎总裁谭待表示,下一个十年非常重要的事是计算范式从云原生进入到AI云原生的新时代。AI云原生的特点是”以GPU为核心”,重新优化计算、存储与网络架构,让GPU可以直接访问存储和数据库,显著降低IO延迟,同时提供更高规模的高速互联和端到端的安全保护。

火山引擎基于AI云原生理念,总结出了从开源模型到企业部署调用的端到端关键步骤,包括模型选择、最佳资源规划、推理部署工程优化、企业级服务调用。这套流程不仅适用于部署DeepSeek系列模型,企业在云上部署其他AI模型时也完全可以参考。火山引擎提供了最大768G显存和最高3.2Tbps高速RDMA互联带宽的高性能计算资源,以及全栈且系统化的推理加速能力。火山引擎还提供了一站式模型部署和定制能力,以及长期技术驱动打造的性价比,价格优惠高达80%。

火山引擎在稳定性和安全性方面给予客户足够的保障。在稳定性方面,火山引擎提供了全面且丰富的检测手段,可在分钟级时间内定位问题实例并完成自愈。在安全性方面,火山引擎基于自研大模型应用防火墙,可提供强大的All in One安全防护能力,足以为用户部署DeepSeek模型保驾护航。

随着DeepSeek系列模型的广泛部署和应用,AI技术的变革已经进入了一个全新的阶段。火山引擎凭借”AI云原生”的理念,展现出了与时俱进的技术优势。从”以GPU为核心”到”以模型为核心”,通过对存储和网络架构的重新设计,以及在性能、稳定性、安全性等多方面的卓越表现,火山引擎AI云原生不仅仅是技术的创新,更是未来十年内推动AI应用蓬勃发展的基础。后DeepSeek-R1时代,火山引擎AI云原生将成为AI应用大爆发的基石,助力各行各业进入更加智能化的时代。

原文和模型

【原文链接】 阅读原文 [ 4597字 | 19分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★