文章摘要

【关 键 词】 大模型推理、显存优化、异构计算、MoE架构、开源框架

清华大学KVCache.AI团队与趋境科技联合推出的KTransformers开源项目,通过技术创新实现了千亿参数模型在消费级硬件上的本地化部署。该项目最新版本支持24G显存环境下运行DeepSeek-R1/V3的671B全参数MoE模型,预处理速度达286 tokens/s,推理生成速度达14 tokens/s,较传统方案实现数量级突破。

针对MoE架构的显存挑战,团队提出GPU/CPU异构计算策略:将稀疏MoE矩阵置于CPU内存处理,稠密矩阵通过GPU加速运算。这种基于计算强度的offload策略,结合4bit量化技术,使显存需求降低至单张RTX 4090显卡即可承载。技术实现中,通过重构MLA算子将KV缓存缩减90%,并采用Marlin量化算子实现GPU计算3.87倍加速,配合CUDA Graph优化将Python框架的调度开销降至单次调用。

在CPU优化方面,整合Intel AMX指令集后预处理速度达到llama.cpp的28倍,使长序列任务的响应时间从分钟级压缩至秒级。实测数据显示,开发者使用3090显卡与200GB内存组合,配合Unsloth优化可实现Q2_K_XL模型9.1 tokens/s的推理速度,验证了方案的实用性。

项目技术架构包含三大创新点:首先,利用MoE模型固有稀疏性实施动态参数加载,通过专家模块并行计算提升资源利用率;其次,开发异构计算调度系统,依据算子计算强度智能分配GPU/CPU任务;最后,构建兼容HuggingFace生态的API接口与Web界面,降低技术迁移门槛。其模板注入框架支持灵活配置量化策略与内核组合,为不同硬件环境提供定制化方案。

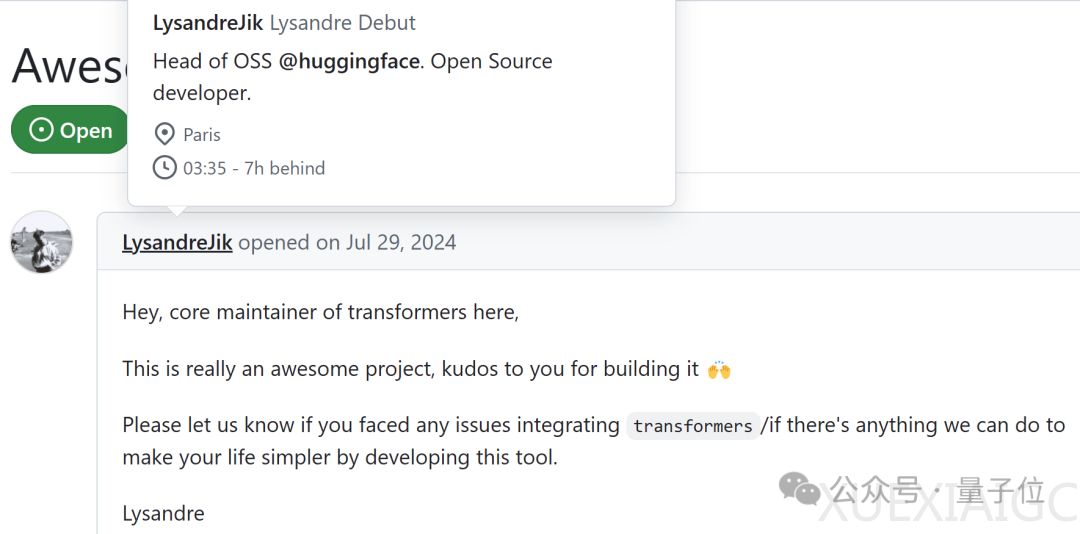

社区应用层面,KTransformers已在localLLaMa社区蝉联热榜首位,获得HuggingFace官方认可。开源48小时内GitHub issues讨论量突破百条,反映出开发者对低成本部署大模型的迫切需求。跨平台支持特性使Windows/Linux用户均可部署,配合YAML配置系统实现从消费显卡到专业计算卡的弹性扩展。该技术的突破,为学术研究提供了无需超算集群的大模型实验平台,可能推动基础模型研究范式的转变。

原文和模型

【原文链接】 阅读原文 [ 1489字 | 6分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-r1

【摘要评分】 ★★★☆☆