文章摘要

【关 键 词】 3D-VLA、生成式、具身智能、多模态、空间推理

这篇新智元报道介绍了一种名为3D-VLA(3D视觉-语言-动作)的新型生成式视觉-语言-行动模型,该模型在多项任务中显著提高了推理、多模态生成和规划的能力。与现有的2D视觉-语言-动作模型相比,3D-VLA模型通过引入具身基础模型,能够无缝连接3D感知、推理和行动,从而更好地模拟人类在思考时引入的世界模型。

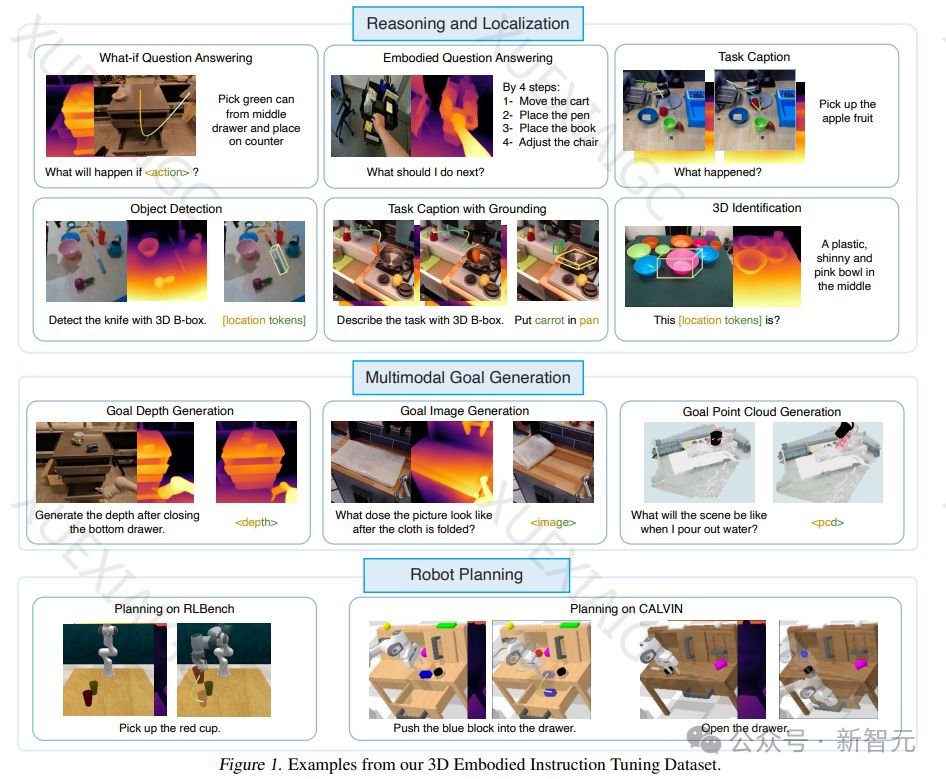

3D-VLA模型建立在基于3D的大型语言模型(LLM)之上,并通过引入交互token来增强模型与3D世界的交互能力。研究人员训练了一系列具身扩散模型,并将其对齐到LLM中,以预测目标图像和点云。此外,研究人员还构建了一个大规模的3D具身指令数据集,以提供足够的3D相关信息和相应的文本指令来训练模型。

3D-VLA模型的骨干网络是在3D-LLM的基础上开发的,通过添加交互token来增强模型与3D世界的交互。这些交互token包括对象token、位置token和场景token,以及用于表示机器人动作的专用标记集。研究人员还提出了一种新框架,将不同形式的扩散模型预训练后对齐到3D-VLA的嵌入空间,以注入目标生成能力。

实验结果表明,3D-VLA模型在3D推理和定位、多模态目标生成和具身行动规划方面均优于现有的2D VLM方法。3D-VLA模型能够利用3D信息进行更准确的空间推理,并通过3D定位标注学习定位相关对象。此外,3D-VLA在多模态目标生成方面表现优异,证实了使用专门为机器人应用设计的数据集来训练世界模型的重要性。在具身行动规划方面,3D-VLA模型在RLBench动作预测任务中超过了基线模型的性能,显示出其规划能力。

总之,3D-VLA模型作为一种新型的生成式视觉-语言-行动模型,在多项任务中表现出显著的优势,展示了其在现实世界中的应用潜力。通过引入具身基础模型和3D数据集,3D-VLA模型能够更好地模拟人类在思考和规划时所依赖的3D物理世界,为机器人控制和具身智能领域带来了新的突破。

原文和模型

【原文链接】 阅读原文 [ 2255字 | 10分钟 ]

【原文作者】 新智元

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★