文章摘要

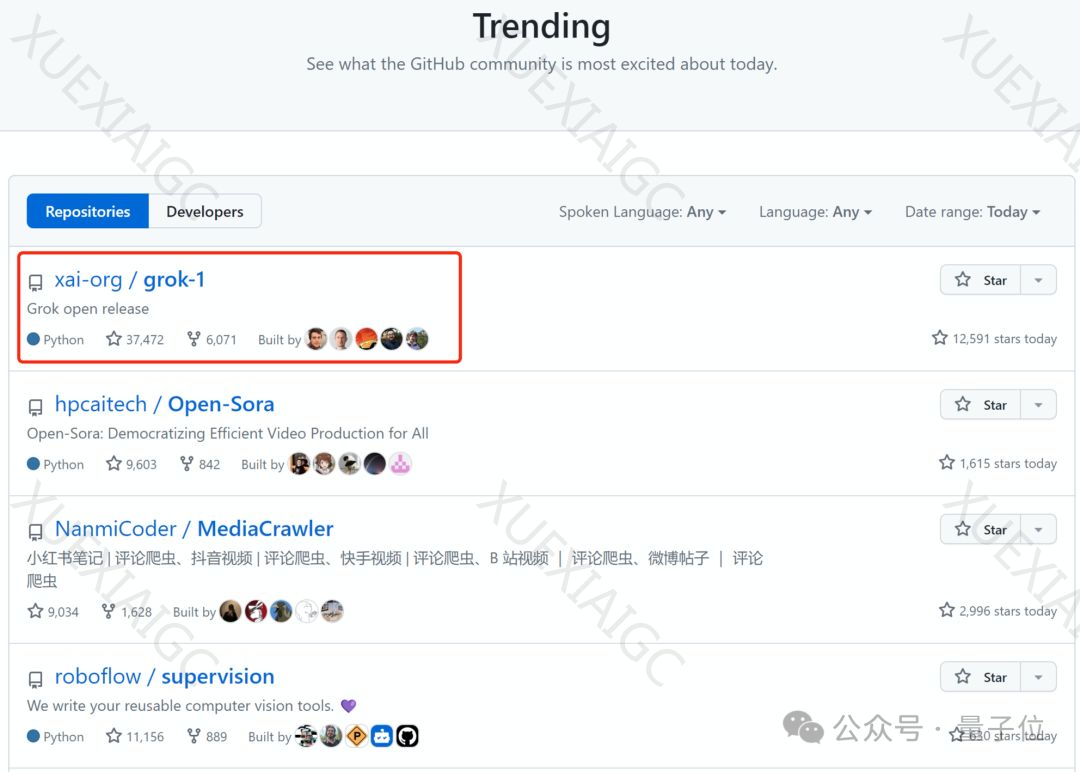

这篇文章介绍了马斯克开源的Grok-1,以及Colossal-AI团队为Grok-1提供的方便易用的Python+PyTorch+HuggingFace版本,能将推理时延加速近4倍。Colossal-AI团队在AI大模型系统优化领域的积累使他们能够支持对Grok-1的张量并行,从而在单台服务器上将推理性能加速近4倍。使用Colossal-AI后,只需运行推理脚本即可自动下载和加载模型权重,推理结果也能保持对齐。Grok-1是一个庞大的模型,采用混合专家(MoE)架构,包含8个专家,总参数量为314B,处理Token时激活参数量为86B。模型的规模较大,需要有足够GPU和内存的机器才能运行。Grok-1采用Apache 2.0许可证,商用友好,目前在GitHub上的标星已达到43.9k Stars。Colossal-AI将在近期进一步推出对Grok-1在并行加速、量化降低显存成本等方面的优化。整体来看,Grok-1的开源和Colossal-AI团队的优化工作为用户提供了更便捷、高效的使用体验。

原文和模型

【原文链接】 阅读原文 [ 697字 | 3分钟 ]

【原文作者】 量子位

【摘要模型】 gpt-3.5-turbo-0125

【摘要评分】 ★☆☆☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...